Einführung in die Sentiment-Analyse

Definition und Bedeutung

Was ist Sentiment-Analyse?

Die Sentiment-Analyse, auch bekannt als Meinungs- oder Stimmungsanalyse, ist ein Feld der Textanalyse, das darauf abzielt, die Stimmung hinter einer Serie von Worten zu identifizieren und zu kategorisieren, um zu verstehen, wie die Schreiberlinge fühlen. Sie kombiniert Methoden aus der Datenverarbeitung, Textanalyse und maschinelles Lernen, um schriftlich festgehaltene Stimmungen wie in Rezensionen, Umfragen, Blogs und anderen Online-Quellen zu bewerten.

Warum ist Sentiment-Analyse wichtig?

In einer Welt, die zunehmend auf Daten und automatisierte Entscheidungsfindung setzt, gibt Sentiment-Analyse Unternehmen einen entscheidenden Einblick in die öffentliche Meinung, Marktstimmung und Kundenerfahrungen. Unternehmen verwenden Sentiment-Analyse, um ihre Produkte und Dienstleistungen zu verbessern, ihre Marketingstrategien anzupassen, die Kundenzufriedenheit zu überwachen und Krisen in sozialen Medien abzuwenden.

Grundlegende Konzepte

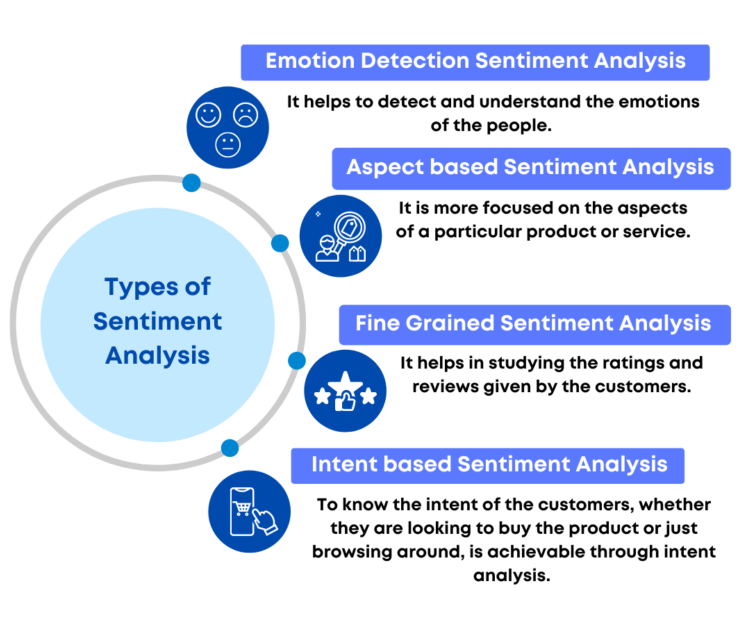

Die Sentiment-Analyse bedient sich unterschiedlicher Techniken, um Emotionen in Texten zu erkennen. Zu den grundlegenden Konzepten gehören die Polarisierung der Stimmung (positiv, negativ, neutral) und die Intensität der Emotion. Moderne Ansätze nutzen komplexere Modelle, die Sarcastic, „Mixed“ oder „Compound“ Emotionen erkennen, um den Nuancen menschlicher Kommunikation gerecht zu werden.

Methodik

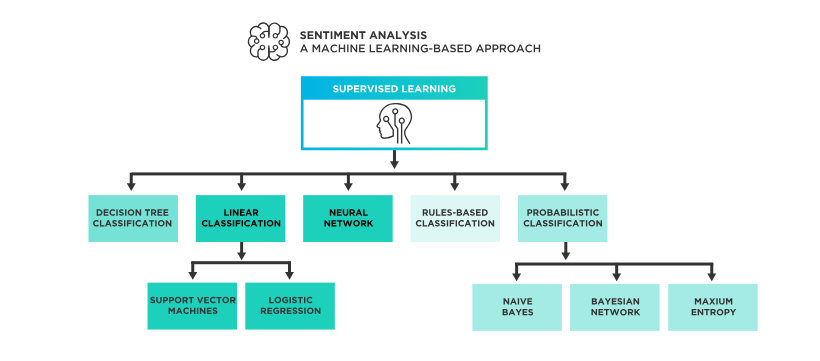

Die Umsetzung von Sentiment-Analysen beruht häufig auf maschinellem Lernen oder auf festgelegten Regeln, wobei beide Herangehensweisen ihre Vor- und Nachteile bieten. Maschinelles Lernen benötigt für gewöhnlich große Mengen an trainierten Daten, um effektiv zu sein, während regelbasierte Systeme starrer sind, aber für Spezifische Anwendungsfälle schneller implementiert werden können.

Anwendungen und Beispielbranchen

- Marketing und Marktforschung: Erfassen der Produktbewertung und Feedback zur weiteren Produktentwicklung.

- Finanzmarktanalyse: Prognostizieren von Markttrends durch Analyse der Stimmung aus Nachrichtenartikeln oder Aktienforen.

- Kundendienst: Automatisches Erkennen von Kundenstimmungen in Support-Tickets oder Kundenfeedback, um Service zu verbessern.

- Politik: Einschätzung öffentlicher Meinungen zu politischen Kampagnen oder Entscheidungen.

Herausforderungen und Entwicklungen

Obwohl Sentiment-Analyse ein mächtiges Werkzeug ist, bleibt es herausfordernd, den Kontext und die Subtilität der menschlichen Sprache zu erfassen. Ironie, Sarkasmus und Doppeldeutigkeit sind ständige Hindernisse für genaue Ergebnisse. Forschung und Entwicklung auf diesem Gebiet sind weiterhin von großer Bedeutung, um Algorithmen zu entwickeln, die mit der Komplexität der menschlichen Sprache und Stimmung umgehen können.

Die Sentiment-Analyse ist ein faszinierender Zweig der Künstlichen Intelligenz und Natural Language Processing (NLP), der kontinuierlich wächst und sich entwickelt, um Unternehmen und Organisationen wertvolle Erkenntnisse aus unstrukturierten Daten zu liefern. Die Technologie wird immer weiter verfeinert, um die emotionale Tiefe besser zu verstehen und nützlichere, genauere Informationen aus Textquellen zu extrahieren.

Anwendungsbereiche der Sentiment-Analyse

Die Sentiment-Analyse, ist eine facettenreiche Technik, die sich in verschiedensten Bereichen als unverzichtbares Instrument etabliert hat, wie zum Beispiel in den folgenden Anwendungsbereichen:

Kundenfeedback und Marktforschung

Einer der prominentesten Einsatzgebiete der Sentiment-Analyse ist das Gebiet der Kundenfeedback-Auswertung. Gemäß einer Studie des Fraunhofer-Instituts ermöglicht die maschinelle Analyse von Kundenmeinungen eine schnelle Reaktion auf Marktänderungen und Kundenbedürfnisse. So können Unternehmen beispielsweise Produktbewertungen und Kundenrezensionen auswerten, um ihre Produkte zu verbessern und kundenspezifische Services zu entwickeln (Fraunhofer, 2018).

Soziale Medien und Online-Reputation

In der heutigen digitalen Ära spielen soziale Medien eine Schlüsselrolle in der Markenkommunikation. Sentiment-Analyse-Tools erlauben es Unternehmen, die Stimmungen und Meinungen in sozialen Medien zu verfolgen und darauf zu reagieren (Meltwater, n.d.). Diese Erkenntnisse sind besonders für das Reputation Management von Bedeutung, um schnell auf negative Äußerungen zu reagieren und Krisenmanagement zu betreiben (Reputation.com).

Politik und öffentliche Meinung

Die Analyse von Stimmungen in Nachrichtenartikeln, Blogs und Foren kann wertvolle Einblicke in die öffentliche Meinung bieten. Politische Organisationen und Nichtregierungsorganisationen nutzen Sentiment-Analyse, um Kampagnenerfolge zu messen, Wählerstimmungen zu analysieren und Debatten zu monitoren (Mindsquare, n.d.).

Finanzmärkte

Im Bereich der Finanzen wird Sentiment-Analyse dazu genutzt, um aus Nachrichtenartikeln, Berichten und sozialen Medien Stimmungsbilder zu den Finanzmärkten zu gewinnen. Diese Informationen können in Anlagestrategien einfließen und zur Vorhersage von Marktbewegungen beitragen (Altexsoft, n.d.).

Kundenservice und CRM

Kundeninteraktionen und -feedback bieten eine Fülle von Informationen, die durch Sentiment-Analyse effektiv genutzt werden können. Support-Tickets, E-Mail-Korrespondenz und Chat-Protokolle können analysiert werden, um den Kundenservice zu verbessern und personalisierte Erfahrungen zu schaffen (Userlike, n.d.).

Gesundheitswesen

Im Gesundheitswesen wird Sentiment-Analyse angewandt, um Patientenfeedback und Erfahrungsberichte auszuwerten. Dies kann Einrichtungen dabei helfen, die Qualität der Versorgung zu verbessern und Patientenzufriedenheit zu steigern (Indatallabs, n.d.).

Produktentwicklung und Innovation

Unternehmen können Sentiment-Analyse nutzen, um Feedback zu ihren Produkten zu sammeln und dieses in den Entwicklungsprozess einfließen zu lassen. Sie bietet damit eine Grundlage für Innovationsprozesse und kann entscheidend zur Produktverbesserung beitragen (Computerwoche, n.d.).

Personalwesen und Mitarbeiterengagement

Auch im Personalwesen kann die Sentiment-Analyse genutzt werden, um Stimmungen und Meinungen von Mitarbeitern aus Umfragen, Feedback-Systemen oder sozialen Netzwerken zu analysieren. So lassen sich Unternehmenskultur verbessern und Mitarbeiterengagement fördern (Forsta, n.d.).

Die vielfältigen Anwendungsbereiche der Sentiment-Analyse zeigen, wie breit gefächert ihr Potenzial ist. Sie hat sich als wertvolles Werkzeug in vielen Branchen etabliert, da sie eine tiefere Einsicht in menschliche Emotionen und Meinungen bietet und damit Entscheidungen auf einer informierteren Basis getroffen werden können. Fortlaufende Fortschritte im Bereich des Maschinellen Lernens und der natürlichen Sprachverarbeitung werden die Fähigkeiten und die Genauigkeit der Sentiment-Analyse in der Zukunft weiter steigern (Alexander Thamm GmbH, n.d.; Symanto, n.d.; Towards Data Science, n.d.).

Geschichte und Entwicklung der Sentiment-Analyse

Die Geschichte dieses in den letzten Jahren rapide gewachsenen Forschungszweiges ist sowohl ebenso faszinierend wie auch tief verwurzelt in verschiedenen Disziplinen der Wissenschaft.

Ursprünge der Sentiment-Analyse

Bereits im 18. und 19. Jahrhundert war man an der Analyse von Textstimmungen interessiert, wie Studien zu Literatur und der Verlauf historischer Ereignisse belegen. Jedoch war die Analyse zu jener Zeit rein manuell und subjektiv, von individuellen Interpreten abhängig. Mit der Digitalisierung der Texte und der Entwicklung der Informatik begann die Sentiment-Analyse, sich als ein eigenständiges Forschungsfeld zu etablieren.

In den frühen 2000er Jahren nahm das Interesse an der Sentiment-Analyse beachtlich zu, hauptsächlich getrieben durch das Wachstum des Internets und die Explosion von Nutzer-generierten Inhalten, wie Produktbewertungen, Blogs, Foren und Sozialen Medien. Die Fähigkeit, automatisch die Stimmung der Menschen, seien es Kundenbewertungen oder öffentliche Meinungen, zu erfassen und auszuwerten, wurde für Unternehmen und Organisationen immer wertvoller.

Frühe Methoden und Fortschritte

Die ersten Ansätze der computergestützten Sentiment-Analyse basierten auf einfachen Lexika, die Wörter in positive, negative oder neutrale Kategorien einordneten. Während diese Herangehensweise grundlegend war, offenbarte sie schnell ihre Grenzen bezüglich Kontextsensitivität und der Komplexität menschlicher Sprache.

Mit dem Fortschritt in der Sprachverarbeitung entwickelten Forscher ausgefeiltere Techniken, wie maschinelles Lernen, um Muster innerhalb der Daten zu erkennen und basierend darauf Stimmungen vorherzusagen. Die Verwendung von Algorithmen wie Naive Bayes, Support Vector Machines und später tiefen neuronalen Netzwerken erlaubte es, wesentlich nuancierter und genauer auf die vielschichtigen Dimensionen der Sprache einzugehen.

Die Rolle von Big Data und KI

Das Aufkommen von Big Data und die Verbesserung von KI-Technologien spielten eine entscheidende Rolle in der Weiterentwicklung der Sentiment-Analyse. Forschungen im Bereich des maschinellen Lernens und der Verarbeitung natürlicher Sprache (NLP) führten zur Entwicklung von Modellen, die in der Lage sind, Ironie, Sarkasmus und kulturelle Nuancen zu verstehen, wodurch die Genauigkeit der Sentiment-Analyse erheblich verbessert wurde.

Deep Learning und neuronale Netzwerke ermöglichten es, aus riesigen Datenmengen zu lernen und Sentiments auf einer feinkörnigeren Ebene zu identifizieren, einschließlich Emotionserkennung auf Satz- und sogar Wortebene. Transformer-Modelle wie BERT (Bidirectional Encoder Representations from Transformers) und GPT-3/4 (Generative Pre-trained Transformer 3/4) haben die Leistungsfähigkeit der Sentiment-Analyse weiter revolutioniert.

Anwendungen und Einfluss

Die praktischen Anwendungen der Sentiment-Analyse sind weitreichend und beeinflussen viele Branchen. Von der Bewertung der Kundenstimmung über soziale Medien-Überwachung und Marktanalyse bis hin zur Finanzwelt, wo sie zur Vorhersage von Aktienkursbewegungen basierend auf den Stimmungen in Nachrichten und Berichten genutzt wird.

Darüber hinaus hat die Sentiment-Analyse auch in die Politikwissenschaft Einzug gehalten, wo sie dazu verwendet wird, die öffentliche Meinung und Reaktionen auf Kampagnen in Echtzeit zu messen. Die zunehmende Integration von Sentiment-Analyse-Tools in Kundendienstsysteme und Gesundheitsdienste zeigt die Vielfalt und die Potenziale des Einsatzes.

Kritische Betrachtungen und zukünftige Entwicklungen

Trotz des beeindruckenden Fortschritts bleibt die Sentiment-Analyse ein komplexes und herausforderndes Feld. Ironie, regionale Ausdrucksweisen und der sich ständig ändernde Gebrauch von Sprache stellen laufend Hürden dar, die es zu überwinden gilt. Darüber hinaus ergeben sich ethische Fragen im Zusammenhang mit Datenschutz und Verzerrungen innerhalb von Trainingsdaten.

Aktuelle Forschungen konzentrieren sich auf die weitere Verfeinerung der Algorithmen und Modelle, um eine noch präzisere und kontextbezogene Analyse von Sentiments zu ermöglichen, sowie auf die Entwicklung von Ansätzen, die fair und ohne Vorurteile Meinungen erfassen können. Mit dem Anstieg an rechnerischer Leistung und der ständigen Weiterentwicklung von Algorithmen ist zu erwarten, dass die Sentiment-Analyse weiter an Bedeutung gewinnen und neue Anwendungsfelder erschließen wird.

Grundlagen der Sentiment-Analyse

Linguistische Prinzipien

Sentiment-Analyse ist ein interdisziplinäres Forschungsfeld, das Techniken aus der Linguistik, Informatik und künstlichen Intelligenz kombiniert, um aus textuellen Daten subjektive Informationen zu gewinnen. Im Rahmen dieses Unterkapitels werden die linguistischen Prinzipien der Sentiment-Analyse ausführlich betrachtet.

Die Rolle der Linguistik in der Sentiment-Analyse

Die Linguistik spielt eine zentrale Rolle in der Sentiment-Analyse, da die Interpretation von Emotionen und Meinungen stark von der Verarbeitung natürlicher Sprache abhängt (Minsky, „Emotion Machine“, dlg.org). Die Auswertung von Sprachstrukturen, lexikalischen Wahlen und syntaktischen Konstruktionen ist entscheidend, um den Ton und die Stimmungen in Texten erfolgreich zu erkennen und zu interpretieren (Pedocs).

Konversationsanalyse, ein Teildisziplin der Linguistik, untersucht, wie Sprecher in einem Dialog Emotionen und Einstellungen vermitteln. Diese Erkenntnisse sind wesentlich für die Entwicklung von Algorithmen, die sprachliche Nuancen erfassen sollen (Wikipedia: Konversationsanalyse, journals.sagepub.com).

Linguistische Methoden und Theorien in der Praxis

Linguistische Methoden, wie die Diskursanalyse und die Pragmatik, sind ebenso bedeutend für die Sentiment-Analyse. Diese Methoden befassen sich damit, wie Bedeutung im Kontext erstellt wird, welche Rolle Implikaturen spielen und wie Intonation das Verständnis von Sentiments beeinflusst (aclanthology.org).

Die Automatisierung der Sentiment-Analyse beruht auf theoretischen Modellen, wie der Valenz-Arousal-Theorie, die Emotionen anhand von zwei Dimensionen kategorisiert: Angenehmheit (Valenz) und Erregungsgrad (Arousal). Diese Modelle helfen, emotionale Zustände einzuordnen und somit computergestützte Analysen zu erleichtern (fortext.net, cloud.google.com).

Anwendung von linguistischen Prinzipien in Sentiment-Analysesystemen

Moderne Sentiment-Analysesysteme nutzen linguistische Prinzipien, um Muster und Strukturen im Text zu erkennen. Dazu zählen die Identifikation von Schlüsselwörtern, die für positive oder negative Emotionen stehen, die Betrachtung von Modifikatoren und Verstärkern (Adverbien, Adjektive) und das Verstehen von Ironie und Sarkasmus (mindsquare.de, landtag.nrw.de).

Sprachwissenschaftler entwickeln lexikonbasierte Ansätze, die Wörterbücher von Emotionsbegriffen verwenden, und maschinenlernbasierte Ansätze, die anhand von trainierten Datensätzen lernen, Emotionen automatisch zu klassifizieren. Diese Datensätze können beispielsweise aus Produktbewertungen oder sozialen Medien stammen und ermöglichen es, verschiedene Sprachstile und Genres zu analysieren (ResearchGate, kobra.uni-kassel.de).

Diskriminierungsrisiken und ethische Aspekte

Eine signifikante Herausforderung der Sentiment-Analyse ist die Vermeidung von Diskriminierung und Bias. Die Untersuchung der linguistischen Prinzipien bietet Einblicke, wie solche Probleme entstehen können, etwa durch verzerrte Trainingsdaten oder die Fehlinterpretation von Kontext und Mehrdeutigkeiten (Antidiskriminierungsstelle, edpb.europa.eu).

Ethik in der Sentiment-Analyse erfordert daher einen sorgfältigen Umgang mit Sprachdaten und einen bewussten Einsatz der entsprechenden Technologien, um zu vermeiden, dass Minderheiten oder einzelne Gruppen vorverurteilt werden (uni-hannover.de, uni-hildesheim.de).

Fazit und Ausblick

Das Verständnis der linguistischen Prinzipien in der Sentiment-Analyse eröffnet neue Perspektiven für die Analyse menschlicher Emotionen und Meinungen. Während computergestützte Methoden immer ausgefeilter werden, bleibt die detaillierte Auseinandersetzung mit Sprachmustern und deren Bedeutungen unverzichtbar für die Genauigkeit und Fairness dieser Systeme.

Die kontinuierliche Entwicklung in diesem Bereich erfordert eine interdisziplinäre Zusammenarbeit, um fortschrittliche Algorithmen zu entwickeln, die in der Lage sind, die Subtilitäten der menschlichen Sprache zu erfassen und adäquat zu interpretieren. Zukünftige Forschung könnte sich darauf konzentrieren, wie Sentiment-Analyse genutzt werden kann, um soziale Dynamiken besser zu verstehen und als Werkzeug für gesellschaftlichen Fortschritt zu fungieren.

Textverarbeitung und Normalisierung in der Sentiment-Analyse

Die Sentiment-Analyse ist ein Bereich des Natural Language Processing (NLP), der darauf abzielt, die Stimmung oder Meinung in Texten zu erkennen und zu klassifizieren. Damit Computer diese Stimmung analysieren können, muss der Text zunächst verarbeitet und normalisiert werden. Dies ist ein entscheidender Schritt, der sich direkt auf die Qualität und Genauigkeit der Analyse auswirkt.

Textverarbeitung

Zu Beginn der Textverarbeitung steht die Datenvorbereitung, bei der Texte aus verschiedenen Quellen gesammelt und bereinigt werden. In der Textanalyse geht es darum, relevante Informationen aus einem Textkorpus zu extrahieren und ihn für die computerbasierte Analyse aufzubereiten.

Tokenisierung

Der erste Schritt ist üblicherweise die Tokenisierung, bei der Text in kleinere Einheiten, sogenannte Tokens, unterteilt wird. Diese Tokens können Wörter, Phrasen oder sogar einzelne Zeichen sein. Tools wie RQDA bieten Funktionen, um diesen Prozess zu unterstützen und zu vereinfachen.

Entfernen von Stoppwörtern

Nach der Tokenisierung folgt häufig das Entfernen von Stoppwörtern. Stoppwörter sind Wörter, die häufig auftreten, aber in der Regel wenig zum Verständnis des Inhalts beitragen, wie zum Beispiel „der“, „und“, „ist“ usw. Verschiedene NLP-Bibliotheken bieten Listen dieser Wörter, die angepasst und erweitert werden können.

Lemmatisierung und Stemming

Lemmatisierung und Stemming sind Techniken, um Wörter auf ihre Grundform zu reduzieren. Lemmatisierung berücksichtigt die Morphologie der Wörter und Stemming schneidet Endungen ab, um auf den Wortstamm zu reduzieren. Diese Schritte helfen, die Vielfalt der Wortformen zu reduzieren und die Datenmenge handhabbarer zu machen.

Der Hauptunterschied liegt darin, dass die Lemmatisierung die morphologische Analyse der Wörter berücksichtigt, um ihre kanonische Form oder das Lemma zu finden, während das Stemming einfach den Wortstamm ohne Berücksichtigung des Kontexts oder der Korrektheit abschneidet.

Hier sind fünf Beispiele, die den Unterschied zwischen Lemmatisierung und Stemming verdeutlichen:

- Laufen

- Lemmatisierung: „laufen“ → „laufen“ (unverändert, da bereits in Grundform)

- Stemming: „laufen“ → „lauf“ (Abschneiden des Suffixes)

- Gelaufen

- Lemmatisierung: „gelaufen“ → „laufen“ (Rückführung auf das Infinitiv-Verb)

- Stemming: „gelaufen“ → „gelauf“ (Abschneiden des Suffixes)

- Bessere

- Lemmatisierung: „bessere“ → „gut“ (Rückführung auf das Adjektiv in Grundform)

- Stemming: „bessere“ → „besser“ (Abschneiden des Suffixes)

- Mäuse

- Lemmatisierung: „Mäuse“ → „Maus“ (Rückführung auf Singularform)

- Stemming: „Mäuse“ → „Mäus“ (Abschneiden des Suffixes)

- Am schnellsten

- Lemmatisierung: „am schnellsten“ → „schnell“ (Rückführung auf das Adjektiv in Grundform)

- Stemming: „am schnellsten“ → „am schnell“ (Einfaches Abschneiden ohne Berücksichtigung der korrekten Wortform)

Diese Beispiele zeigen, dass Lemmatisierung darauf abzielt, das korrekte Lemma eines Wortes zu finden, welches oft die Basisform (wie Infinitiv bei Verben oder Singular bei Substantiven) ist. Stemming hingegen schneidet einfach Endungen ab, was oft zu Formen führt, die keine gültigen Wörter sind. Lemmatisierung ist komplexer und berücksichtigt den linguistischen Kontext des Wortes, während Stemming einfacher ist und schneller ausgeführt werden kann.

Groß- und Kleinschreibung

Das Umwandeln aller Buchstaben in Kleinschreibung ist eine weitere gängige Normalisierungstechnik, um die Konsistenz im Text zu gewährleisten und die Anzahl unterschiedlicher Tokens zu verringern.

Normalisierung

Normalisierung umfasst eine Reihe von Prozessen, um Textdaten in ein einheitliches Format zu überführen. Es handelt sich um eine Vorverarbeitung, die dazu dient, die Varianz im Text zu minimieren, um die Leistung von Algorithmen im maschinellen Lernen zu verbessern.

Min-Max-Normalisierung

Bei der Min-Max-Normalisierung werden numerische Werte im Text (z. B. Daten) in einen Standardbereich umgerechnet (typischerweise zwischen 0 und 1), was vor allem in Bezug auf die Maßeinheiten Konsistenz schafft.

Hier sind einige Beispiele, wie das in einem Textkorpus aussehen könnte:

- Vor der Normalisierung: „Im Jahr 1990 hatte die Stadt 500.000 Einwohner.“ Nach der Normalisierung: „Im Jahr 0.72 hatte die Stadt 0.5 Einwohner.“ (angenommen, das Jahr 1990 wird relativ zu einem Bereich von 1900 bis 2000 und die Bevölkerungszahl relativ zu 0 bis 1 Million normalisiert)

- Vor der Normalisierung: „Das Produkt kostet 300 Euro.“ Nach der Normalisierung: „Das Produkt kostet 0.3 Euro.“ (angenommen, der Preisbereich wird von 0 bis 1000 Euro normalisiert)

- Vor der Normalisierung: „Die Temperatur beträgt 20 Grad Celsius.“ Nach der Normalisierung: „Die Temperatur beträgt 0.4.“ (angenommen, die Temperatur wird in einen Bereich von 0 bis 50 Grad normalisiert)

- Vor der Normalisierung: „Die Reise dauerte 10 Stunden.“ Nach der Normalisierung: „Die Reise dauerte 0.42 Stunden.“ (angenommen, die Dauer wird relativ zu einem Bereich von 0 bis 24 Stunden normalisiert)

- Vor der Normalisierung: „Die Distanz beträgt 150 Kilometer.“ Nach der Normalisierung: „Die Distanz beträgt 0.15.“ (angenommen, die Distanz wird in einen Bereich von 0 bis 1000 Kilometer normalisiert)

Batch-Normalisierung und Layer-Normalisierung

Diese Techniken stammen aus dem Bereich des Deep Learning und werden eingesetzt, um die Eingabewerte für jede Schicht eines Netzwerks zu normalisieren. Auch wenn sie primär bei der Bildverarbeitung verwendet werden, finden sie in modifizierter Form Anwendung bei der Verarbeitung von Textdaten in tiefen neuronalen Netzwerken.

Die Beispiele für diese Arten der Normalisierung sind eher abstrakt und technisch, da sie auf die internen Repräsentationen von Daten im Netzwerk angewendet werden:

- Vor der Normalisierung: Eingabewerte eines neuronalen Netzwerks mit hoher Varianz zwischen den Neuronen. Nach der Normalisierung: Eingabewerte sind über alle Neuronen hinweg standardisiert, was die Stabilität des Trainings verbessert.

- Vor der Normalisierung: Unterschiedliche Skalierung der Eingabedaten führt zu langsamer Konvergenz beim Training. Nach der Normalisierung: Einheitliche Skalierung führt zu einer effizienteren Gewichtsanpassung und schnellerer Konvergenz.

- Vor der Normalisierung: Eingabedaten in tieferen Schichten des Netzwerks sind stark korreliert. Nach der Normalisierung: Reduzierung der Korrelation zwischen den Eingabedaten, was zu einer verbesserten Unabhängigkeit der Merkmale führt.

- Vor der Normalisierung: Ein neuronales Netzwerk ist anfällig für das Problem des verschwindenden oder explodierenden Gradienten. Nach der Normalisierung: Stabilisierung der Gradienten, was das Training von tiefen Netzwerken erleichtert.

- Vor der Normalisierung: Unterschiedliche Aktivierungsniveaus in verschiedenen Schichten des Netzwerks. Nach der Normalisierung: Angleichung der Aktivierungsniveaus über das Netzwerk, was zu einer gleichmäßigeren Informationsverarbeitung führt.

Wissensgraphen und kontextuelle Intelligenz

Wissensgraphen sind eine aufkommende Methode, um semantische Beziehungen und Bedeutungen in Textdaten zu berücksichtigen. Ontotext bietet solche Analysen an, die durch das Verknüpfen von Textdaten mit externem Kontext eine reichhaltigere und tiefere Analyse ermöglichen.

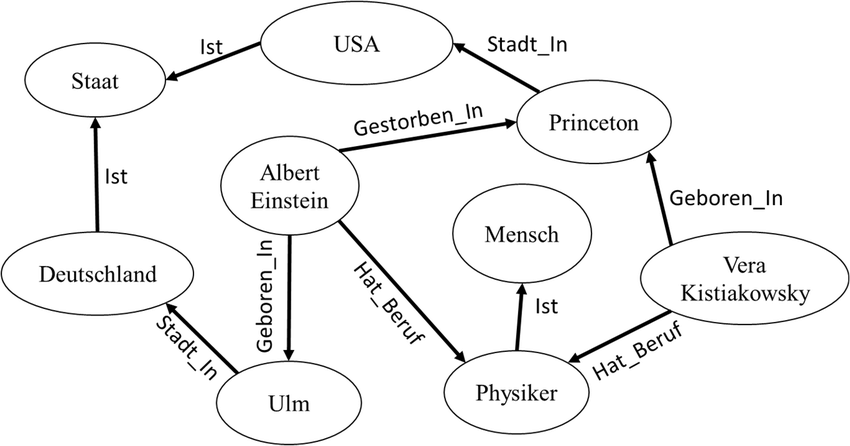

Die Funktionsweise der Wissensgraphen möchte ich anhand eines Beispiels verdeutlichen:

Ausgangssituation: In einer fiktiven Forschungsdatenbank für historische Persönlichkeiten wollen wir die Beziehungen zwischen verschiedenen Individuen, ihren Berufen, den Orten, an denen sie geboren wurden oder gestorben sind, und den Staaten, zu denen diese Orte gehören, verstehen.

Ziel: Das Ziel ist es, ein klareres Bild der Verbindungen zwischen Personen, Orten und Staaten zu erhalten und wie diese Elemente zusammenwirken. Zum Beispiel wollen wir verstehen, welche berühmten Physiker in Deutschland geboren wurden und in den USA gestorben sind.

Prozess:

- Aufbau des Wissensgraphen:

- Wir nutzen den vorhandenen Wissensgraphen, um unsere Datenbank zu erstärken. Der Graph zeigt bereits Verbindungen zwischen Personen wie Albert Einstein und Vera Kistiakowsky, ihren Berufen (Physiker), und Orten (Ulm, Princeton), sowie den zugehörigen Staaten (Deutschland, USA).

- Extraktion und Verknüpfung von Informationen:

- Aus dem Graphen entnehmen wir, dass Albert Einstein in Deutschland, genauer in Ulm, geboren wurde, was ein Teil des Staates Deutschland ist. Weiterhin wurde er als Physiker klassifiziert und ist in den USA, in Princeton, gestorben.

- Ähnlich verhält es sich mit Vera Kistiakowsky, die ebenfalls den Beruf Physiker hatte, jedoch fehlen in diesem Graphen Informationen über Geburts- und Sterbeort.

- Anreicherung und Analyse:

- Um unseren Wissensgraphen zu erweitern, suchen wir in unserer Datenbank nach weiteren Physikern, die ähnliche Verbindungen wie Albert Einstein haben könnten. Wir suchen nach weiteren Individuen, die in Deutschland geboren wurden und in den USA gestorben sind.

- Gleichzeitig erweitern wir die Informationen über Vera Kistiakowsky, indem wir ihren Geburts- und Sterbeort recherchieren und diese Informationen dem Graphen hinzufügen.

- Visualisierung und Erkenntnisgewinnung:

- Die visuelle Darstellung unseres erweiterten Wissensgraphen hilft uns, Muster zu erkennen, wie zum Beispiel die Migration von Wissenschaftlern im 20. Jahrhundert oder die Beziehung zwischen Geburtsorten und späteren wissenschaftlichen Leistungen.

- Wir können auch die Bedeutung von Städten wie Princeton für die wissenschaftliche Gemeinschaft erkennen, indem wir sehen, wie viele bedeutende Wissenschaftler dort gearbeitet haben oder gestorben sind.

- Schlussfolgerungen:

- Durch die Analyse des Wissensgraphen verstehen wir besser, wie die historische und geographische Bewegung von Wissenschaftlern wie Physikern die wissenschaftliche Entwicklung beeinflusst hat.

- Diese Informationen können genutzt werden, um Bildungseinrichtungen, Forschungsinstitutionen und politische Entscheidungsträger über die historischen Trends und ihre möglichen Auswirkungen auf die heutige Wissenschaftslandschaft zu informieren.

Ergebnis: Mit Hilfe des Wissensgraphen konnten wir umfassende Einsichten in die Beziehungen und historischen Muster von Persönlichkeiten in der Wissenschaft gewinnen. Dies ermöglicht es uns, nicht nur isolierte Datenpunkte zu betrachten, sondern auch die reichen Kontexte und Netzwerke, die diese Persönlichkeiten umgeben und geformt haben.

Qualitative Inhaltsanalyse

Die qualitative Inhaltsanalyse ist eine Forschungsmethode, die es ermöglicht, strukturiert und systematisch Textdaten zu analysieren. Nach dem von Philipp Mayring entwickelten Ansatz wird der Text in kleinere Einheiten zerlegt, die dann codiert und interpretiert werden. Dieser Prozess beruht auf einer Reihe von Regeln und Kategorien, die aus dem Text selbst oder aus theoretischen Überlegungen abgeleitet sind. Ziel ist es, ein tiefes Verständnis des Textes und seiner Bedeutungsebenen zu erlangen.

Mayrings Ansatz ist besonders hilfreich, wenn es darum geht, komplexe Textdaten zu analysieren, wie sie beispielsweise in der Sentiment-Analyse vorkommen. Hierbei werden Texte nicht nur auf ihren faktischen Inhalt hin untersucht, sondern auch bezüglich der darin ausgedrückten Gefühle und Meinungen. Durch die Definition von affektiven Codes können Forschende subjektive Aussagen systematisch klassifizieren und so die vorherrschenden Stimmungen und Einstellungen in Textdaten erfassen.

Beispiel für die Anwendung der Qualitativen Inhaltsanalyse in der Sentiment-Analyse:

Angenommen, wir möchten die Kundenbewertungen eines neuen Smartphones analysieren, um die Stimmung der Kunden gegenüber dem Produkt zu verstehen. Die Bewertungen liegen in Textform vor und enthalten eine Mischung aus Fakten und Meinungen.

- Datensammlung:

- Zunächst sammeln wir eine repräsentative Stichprobe von Kundenbewertungen aus verschiedenen Quellen wie Online-Shops, Foren und sozialen Medien.

- Entwicklung des Codierleitfadens:

- Wir entwickeln einen Codierleitfaden, der Kategorien enthält, die sowohl positive als auch negative Gefühle widerspiegeln. Zum Beispiel könnten Kategorien für positive Sentiments „Zufriedenheit“, „Begeisterung“ und „Empfehlungsbereitschaft“ sein, während Kategorien für negative Sentiments „Enttäuschung“, „Frustration“ und „Kritik“ umfassen könnten.

- Codierung des Materials:

- Jede Kundenbewertung wird nun sorgfältig gelesen und die relevanten Textstellen den entsprechenden affektiven Codes zugeordnet. Zum Beispiel wird der Satz „Ich liebe das klare Display und die lange Akkulaufzeit des Smartphones!“ dem positiven Code „Begeisterung“ zugeordnet.

- Interpretation der Ergebnisse:

- Nachdem alle Daten codiert wurden, analysieren wir die Häufigkeit und den Kontext der verschiedenen Codes, um die allgemeine Stimmung der Kundenbewertungen zu interpretieren. Wenn zum Beispiel der Code „Begeisterung“ deutlich häufiger vorkommt als „Frustration“, könnten wir schließen, dass die Kunden im Allgemeinen sehr zufrieden mit dem Smartphone sind.

- Exemplarische Verdichtung:

- Für eine detailliertere Analyse könnte man einzelne Bewertungen herausgreifen, die exemplarisch für bestimmte Sentiments stehen. Ein Kunde könnte beispielsweise geschrieben haben: „Ich bin so enttäuscht von der Kamera. Bei schlechten Lichtverhältnissen sind alle Bilder unscharf.“ Diese Bewertung würde den negativen Code „Enttäuschung“ erhalten und könnte im Bericht detailliert diskutiert werden, um die Probleme mit der Kamera zu veranschaulichen.

Durch die qualitative Inhaltsanalyse nach Mayring können wir also nicht nur quantitative Aussagen über die Häufigkeit bestimmter Sentiments treffen, sondern auch die tiefer liegenden Gründe für die Kundeneinstellungen verstehen. Dies ermöglicht es Unternehmen, gezielte Verbesserungen vorzunehmen und auf Kundenbedürfnisse einzugehen.

Implementierung und Tools

Für die Umsetzung stehen zahlreiche Tools zur Verfügung, darunter

- R-Pakete wie tm (Text Mining Package) und sentimentr,

- Python-Bibliotheken wie NLTK und TextBlob,

- sowie Plattformen wie Google Cloud Natural Language API und Amazon Comprehend, die Funktionen für die Sentiment-Analyse anbieten.

Beim Aufbau einer Pipeline für die Sentiment-Analyse ist es wichtig, die genannten Schritte der Textverarbeitung und Normalisierung sorgfältig zu planen und anzuwenden, um die Grundlagen für eine verlässliche und aussagekräftige Analyse zu legen.

Feature-Extraktion in der Sentiment-Analyse

Zentral für die Sentiment-Analyse ist die Feature-Extraktion, bei der es darum geht, aus Textdaten Muster oder Eigenschaften (Features) zu gewinnen, die für das Erkennen von Sentiments hilfreich sind.

Was ist Feature-Extraktion?

Feature-Extraktion ist ein Prozess, bei dem aus Rohdaten relevante Informationen extrahiert werden, um maschinelle Lernmodelle effektiv zu trainieren. Bei der Analyse von Texten kann dies beispielsweise das Herausfiltern bestimmter Wörter, Phrasen oder syntaktischer Strukturen sein. Die Qualität und Relevanz der extrahierten Features können einen signifikanten Einfluss auf die Leistung des Machine Learning-Modells haben.

Methoden der Feature-Extraktion

1. Bag of Words (BoW):

Das BoW-Modell ist eine der einfachsten Techniken zur Feature-Extraktion. Es wandelt Text in einen Satz von Features um, indem es die Häufigkeit der Wörter im Text zählt, ohne deren Reihenfolge oder Kontext zu berücksichtigen. Scikit-learn bietet ausgezeichnete Werkzeuge zur Implementierung des BoW-Modells (http://scikit-learn.org/stable/modules/feature_extraction.html).

2. TF-IDF (Term Frequency-Inverse Document Frequency):

TF-IDF ist eine statistische Methode, die gewichtet, wie wichtig ein Wort in einem Dokument im Vergleich zu einer Sammlung von Dokumenten ist. Dies reduziert die Gewichtung von häufig vorkommenden Wörtern und erhöht die Gewichtung von Wörtern, die seltener im gesamten Korpus auftreten.

3. Word Embeddings:

Wort-Einbettungen wie Word2Vec, GloVe oder FastText wandeln Wörter in dichte Vektoren um, die semantische Ähnlichkeiten zwischen den Wörtern einfangen. Diese Techniken können dazu beitragen, tiefer liegende semantische Dimensionen zu erfassen.

4. Entity & Aspect Extraction:

Entities (Namen, Orte, Organisationen) und Aspekte (spezifische Eigenschaften von Produkten oder Dienstleistungen) können wichtige Hinweise auf die Sentiments in einem Text geben. Verschiedene Tools und Frameworks wie Google Cloud Natural Language (https://cloud.google.com/natural-language/docs/basics?hl=de) und MonkeyLearn (https://monkeylearn.com/blog/entity-extraction/) bieten Funktionen, um diese Informationen aus Texten zu extrahieren.

5. Syntactic Parsing:

Das syntaktische Parsing hilft, die grammatische Struktur von Sätzen zu verstehen. Dependenz-Parser können Stimmung tragende Phrasen identifizieren und verstärken, zum Beispiel durch Negationen oder Intensivierungen.

6. Feature Selection:

Nicht alle extrahierten Features tragen gleichmäßig zur Sentiment-Detektion bei. Verfahren zur Feature-Selection wie „Chi-squared tests“ oder „Mutual Information“ können dazu beitragen, die Feature-Sets zu verfeinern und zu optimieren.

Bedeutung im Kontext der Sentiment-Analyse

Für die Sentiment-Analyse sind Features unerlässlich, um zwischen verschiedenen Sentiments, wie Positivität, Neutralität und Negativität, zu unterscheiden. So können spezifische adjektivische oder adverbiale Modifikatoren sowie die Präsenz bestimmter Schlüsselwörter einen starken Indikator für das Vorliegen eines bestimmten Sentiments darstellen. Insbesondere im Bereich des Social Media Monitorings, wo beispielsweise Unternehmen an der Analyse der öffentlichen Meinung zu ihren Produkten interessiert sind, spielt die Sentiment-Analyse eine große Rolle und beeinflusst strategische Unternehmensentscheidungen (https://sproutsocial.com/insights/sentiment-analysis/).

Herausforderungen der Feature-Extraktion

Trotz der Leistungsfähigkeit der o.g. Methoden der Feature-Extraktion gibt es Herausforderungen wie Sarkasmus, Mehrdeutigkeit und Kontextabhängigkeit, die die Analyse erschweren. Zudem kann die Sentiment-Analyse über verschiedene Domainen hinweg variieren, was die Notwendigkeit einer angepassten Feature-Extraktion unterstreicht.

Die Grundlagen der Sentiment-Analyse und deren Techniken zur Feature-Extraktion werden in zahlreichen wissenschaftlichen Publikationen, Lehrmaterialien und Online-Ressourcen behandelt. Hervorzuheben sind Arbeiten aus dem Diesner Lab, von Roman Klinger und verschiedene Artikel und Diskussionen auf Foren wie Data Science Stack Exchange.

Die Auswahl und Aufbereitung der Features ist maßgeblich für den Erfolg der Sentiment-Analyse und bleibt ein aktives Forschungsfeld in der Literatur und Anwendungsbereiche, die von Market Research bis Healthcare reichen.

Klassifikation von Sentiments

Einleitung

Die Sentiment-Klassifikation bildet einen integralen Bestandteil der computergestützten Sentiment-Analyse, welche die affektiven Zustände und subjektiven Informationen innerhalb textueller Daten extrahiert und quantifiziert. Dieses Unterkapitel strebt danach, eine umfassende und detaillierte Einführung in die technischen Grundlagen und theoretischen Konzepte der Sentiment-Klassifikation zu liefern, gestützt auf aktuelle wissenschaftliche Erkenntnisse und praktische Anwendungen.

Definition und Zielsetzung

Die Sentiment-Klassifikation ist ein Teilbereich des Natural Language Processing (NLP), der sich auf die automatisierte Identifikation und Kategorisierung subjektiver Informationen in Texten konzentriert. Der Prozess beinhaltet das Zuordnen von Textsegmenten zu spezifischen affektiven Kategorien, üblicherweise differenziert als positiv, negativ und neutral. Ziel ist es, aus einer großen Menge an unstrukturierten Textdaten nutzbare Informationen über individuelle und kollektive Einstellungen, Meinungen und Emotionen zu extrahieren. Diese Informationen sind für Akteure in der Wirtschaft, in Forschungseinrichtungen und sozialen Institutionen von unschätzbarem Wert, da sie tiefergehende Einsichten in Konsumentenverhalten, öffentliche Meinungsbilder und soziokulturelle Dynamiken ermöglichen.

Methodologische Ansätze

Die Klassifikation von Sentiments implementiert ein Spektrum an methodologischen Ansätzen, die von heuristischen bis zu modellbasierten Techniken reichen. Auf der einen Seite stehen lexikalische Ansätze, die sich auf vordefinierte Listen von Schlüsselwörtern und Phrasen mit bekannten affektiven Werten stützen, wie beispielsweise das Harvard IV-4 Psychosocial Dictionary oder SentiWordNet.

Auf der anderen Seite haben sich maschinelle Lernansätze, insbesondere tiefgreifende neuronale Netzwerkarchitekturen, als besonders mächtig erwiesen. Modelle wie BERT (Bidirectional Encoder Representations from Transformers) nutzen Transformer-Architekturen, um kontextuelle Wortbedeutungen durch bidirektionale Kontextualisierung zu erfassen. Dies ermöglicht eine präzisere Analyse von Sentiments, auch unter Berücksichtigung von Ironie, Sarkasmus und impliziten Bedeutungen. Jüngste Forschungen, darunter die von Roman Klinger, haben die Grenzen dieser Ansätze erweitert, indem sie kontextbezogene Feinheiten und semantische Relationen in die Klassifikationsprozesse integrieren.

Praktische Anwendung

Die praktische Anwendung der Sentiment-Klassifikation erstreckt sich über diverse Domänen. Unternehmen nutzen sie, um aus Produktbewertungen, Kundenfeedback und sozialen Medien Stimmungsbilder zu generieren. In der Marktanalyse ermöglicht die fortwährende Entwicklung neuer Metriken und Analyseverfahren eine zunehmend differenzierte Interpretation von Daten und damit eine verfeinerte Verbraucher- und Markteinsicht.

Beispiel einer Sentiment-Analyse: Eine Rezension könnte lauten: „Das X-Phone 3000 hat ein beeindruckendes Display, aber die Akkulaufzeit ist enttäuschend.“

- Das BERT-Modell erkennt „beeindruckend“ als positiv für das Display und „enttäuschend“ als negativ für die Akkulaufzeit.

- Diese Rezension würde daher gemischte Sentiments reflektieren: positiv für die Displayqualität und negativ für die Batterieleistung.

Ethische Betrachtung

Ethische Überlegungen spielen in der Sentiment-Klassifikation eine entscheidende Rolle, insbesondere hinsichtlich des Datenschutzes und der Informationsautonomie der Individuen. Der verantwortungsvolle Umgang mit personenbezogenen Meinungsäußerungen ist von zentraler Bedeutung. Institutionen wie der Deutsche Ethikrat haben diesbezüglich Stellungnahmen veröffentlicht, die eine normative Grundlage für den ethischen Einsatz KI-basierter Analysetechnologien bieten.

Schlussfolgerung

Die Sentiment-Klassifikation ist eine fortgeschrittene und sich kontinuierlich entwickelnde Disziplin, die ein fundiertes Verständnis von maschinellem Lernen, linguistischen Prinzipien und ethischen Standards erfordert. Die zukünftigen Entwicklungen in diesem Bereich versprechen ein erweitertes Verständnis menschlicher Emotionen und Meinungen sowie deren Auswirkungen auf gesellschaftliche und geschäftliche Entscheidungen.

Methoden der Sentiment-Analyse

Regelbasierte Ansätze und lexikonbasierte Ansätze in der Sentiment-Analyse

Einleitung

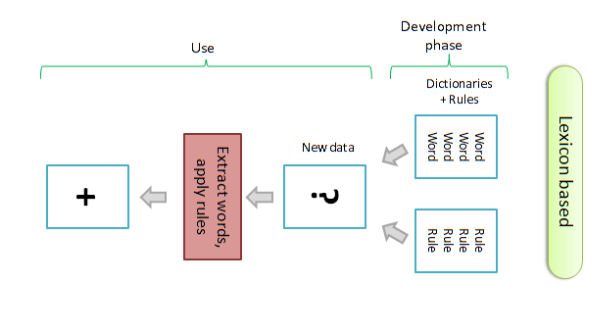

In der Welt der Sentiment-Analyse ergänzen sich regelbasierte und lexikonbasierte Ansätze, um Texte auf ihre emotionale Färbung hin zu analysieren. Während regelbasierte Systeme komplexe linguistische Regeln anwenden, nutzen lexikonbasierte Methoden vordefinierte Sammlungen von emotional gewichteten Wörtern.

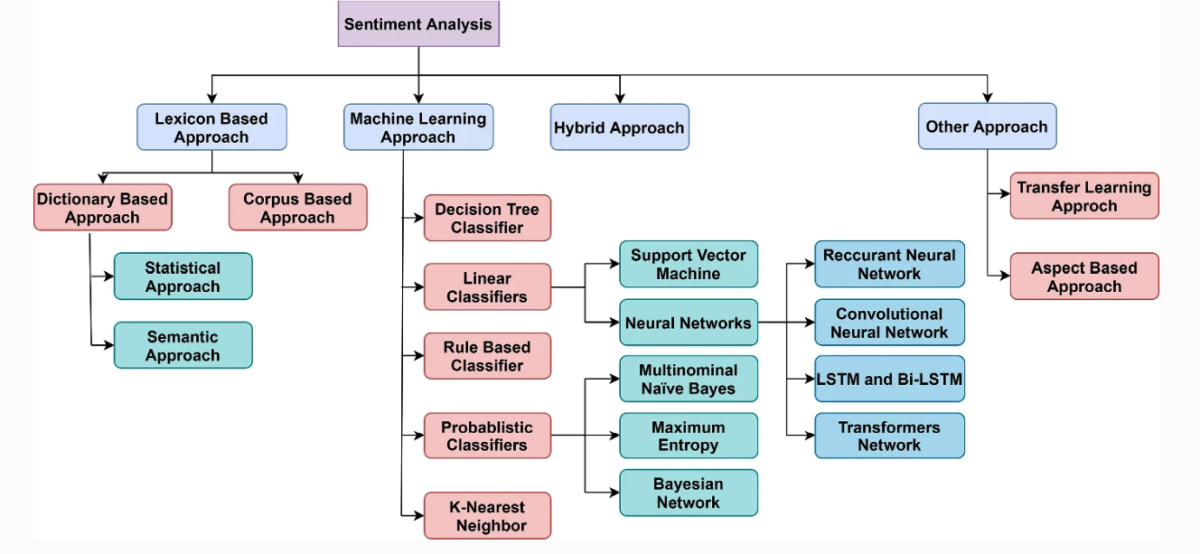

Grundprinzipien

Regelbasierte Ansätze stützen sich auf ein Regelwerk, das linguistische Muster und Strukturen erfasst, um den Kontext und die Nuancen der Sprache zu interpretieren. Sie sind in der Lage, die sentimentale Ausrichtung von Wörtern im Satzbau zu erfassen, etwa durch Erkennung von Ironie oder Negationen. Lexikonbasierte Ansätze hingegen verwenden ein Sentiment-Lexikon – beim Dictionary Based Approach oft manuell erstellt, wobei der Statistical Approach auf Frequenzanalysen und der Semantic Approach auf die Beziehungen der Wörter im Kontext setzt. Der Corpus Based Approach extrahiert und lernt Sentiment-Werte aus einem annotierten Textkorpus, was eine dynamische Anpassung an den Sprachgebrauch ermöglicht.

Unterscheidung

Die Unterscheidung zwischen regelbasierten und lexikonbasierten Ansätzen liegt in der Flexibilität und Tiefe der Analyse. Regelbasierte Methoden sind agil und kontextsensitiv, aber oft komplex in der Entwicklung. Lexikonbasierte Methoden bieten hingegen eine schnellere und direkt umsetzbare Analyse, benötigen jedoch eine Kombination von statistischen und semantischen Techniken, um präzise zu sein. Der Corpus Based Approach erweitert die lexikonbasierten Methoden um eine lernfähige Komponente, die in der Lage ist, sich an neue Ausdrucksweisen anzupassen. Zusammen können diese Ansätze die Präzision der Sentiment-Analyse verbessern und ein umfassendes Verständnis von Textdaten ermöglichen.

Lexikonbasierte Ansätze

- Wortlisten: Lexikonbasierte Ansätze verwenden Listen von Wörtern mit vorab zugewiesenen Sentiment-Werten. Diese Listen, oft als „Sentiment-Lexika“ bezeichnet, enthalten Wörter, die positiv, negativ oder neutral geladen sind.

- Einfache Bewertung: Die Sentiment-Analyse basiert auf der Summierung der Sentiment-Werte der Wörter, die im Text vorkommen. Manche Modelle berücksichtigen auch die Intensität der Sentiments durch gewichtete Werte.

- Keine oder geringe Kontextberücksichtigung: Traditionelle lexikonbasierte Ansätze berücksichtigen selten den Kontext, in dem ein Wort verwendet wird, was zu Ungenauigkeiten führen kann, insbesondere bei Ironie, Sarkasmus oder doppelsinnigen Ausdrücken.

Regelbasierte Ansätze

- Komplexe Regeln: Regelbasierte Ansätze nutzen ein Set von definierten Regeln, die auf die Textstruktur und -syntax eingehen. Diese Regeln können sich auf Wortkombinationen, Satzbau, Satzzeichen und weitere linguistische Faktoren beziehen.

- Erweiterte Logik: Die Regeln können komplex sein und beispielsweise die Verstärkung oder Abschwächung von Sentiments durch Modifikatoren (sehr, kaum), Negationen (nicht, kein) oder Konjunktionen (aber, jedoch) einbeziehen.

- Kontextbewusstsein: Regelbasierte Ansätze können mehr Kontext einbeziehen als einfache lexikonbasierte Modelle. Sie können spezifische sprachliche Muster identifizieren und sind potenziell besser darin, komplexere sprachliche Nuancen zu erkennen.

Gemeinsamkeiten

Beide Ansätze haben das Ziel, Texte auf der Basis von vordefinierten Sentiment-Indikatoren zu analysieren, und beide können ohne maschinelles Lernen auskommen. Zudem können lexikonbasierte Ansätze Teil eines regelbasierten Systems sein, wenn die Wörter des Lexikons durch zusätzliche Regeln ergänzt werden.

Kombinierte Ansätze

In der Praxis werden lexikon- und regelbasierte Ansätze oft kombiniert, um die Stärken beider Methoden zu nutzen und ihre Schwächen zu kompensieren. Zum Beispiel kann ein regelbasiertes System ein Sentiment-Lexikon verwenden, um grundlegende Sentiment-Werte zu erhalten, und dann zusätzliche Regeln anwenden, um den Kontext und die Syntax für eine genauere Sentiment-Analyse zu berücksichtigen.

Beispiele

lexikonbasierte Klassifikation

Lexikonbasierte Sentiment-Analyse: Normales Kundenfeedback

Kundenfeedback: „Ich bin sehr zufrieden mit dem Service im Café. Die Mitarbeiter sind immer freundlich und der Kaffee schmeckt hervorragend.“

Lexikonbasierte Klassifikation:

- Positive Wörter wie „sehr zufrieden“, „freundlich“ und „hervorragend“ sind wahrscheinlich im Sentiment-Lexikon als positiv verzeichnet.

- Der lexikonbasierte Ansatz würde dieses Feedback ebenfalls als positiv klassifizieren, da die verwendeten Wörter positiv konnotiert sind.

Lexikonbasierte Sentiment-Analyse: Ironisches Kundenfeedback

Kundenfeedback: „Großartig, ich musste nur 30 Minuten auf meinen Kaffee warten. So schnell wie ein Blitz.“

Lexikonbasierte Klassifikation:

- Wörter wie „Großartig“ und „schnell“ könnten im Sentiment-Lexikon positiv bewertet sein.

- Ein lexikonbasierter Ansatz würde dieses Feedback vermutlich fälschlicherweise als positiv klassifizieren, da er die ironische Bedeutung nicht erfassen kann.

Lexikonbasierte Sentiment-Analyse: Zynisches Kundenfeedback

Kundenfeedback: „Es ist immer so wunderbar, wenn der Kaffee so lauwarm serviert wird, dass ich meine Hände kaum aufwärmen kann.“

Lexikonbasierte Klassifikation:

- Das Wort „wunderbar“ könnte im Lexikon als positiv verzeichnet sein.

- Ähnlich wie beim regelbasierten Ansatz würde auch der lexikonbasierte Ansatz wahrscheinlich das Feedback als positiv klassifizieren, da er nicht in der Lage ist, den zynischen Kontext zu erkennen.

Lexikonbasierte Sentiment-Analyse: Sarkastisches Kundenfeedback

Kundenfeedback: „Was für eine Freude, dass mein Espresso so stark verdünnt war, dass ich fast dachte, es wäre Wasser.“

Lexikonbasierte Klassifikation:

- „Freude“ würde wahrscheinlich als positives Wort im Lexikon geführt.

- Ohne die Fähigkeit, Sarkasmus zu identifizieren, würde der lexikonbasierte Ansatz dieses Feedback fälschlicherweise als positiv einstufen.

regelbasierte Sentiment-Analyse

Regelbasierte Sentiment-Analyse: Normales Kundenfeedback

Kundenfeedback: „Ich bin sehr zufrieden mit dem Service im Café. Die Mitarbeiter sind immer freundlich und der Kaffee schmeckt hervorragend.“

Regelbasierte Klassifikation:

- Positive Wörter wie „sehr zufrieden“, „freundlich“ und „hervorragend“ werden von der regelbasierten Methode erkannt.

- Das Feedback wird als positiv klassifiziert.

Regelbasierte Sentiment-Analyse: Ironisches Kundenfeedback

Kundenfeedback: „Großartig, ich musste nur 30 Minuten auf meinen Kaffee warten. So schnell wie ein Blitz.“

Regelbasierte Klassifikation:

- Positive Wörter wie „Großartig“ und eine scheinbar positive Phrase „schnell wie ein Blitz“ werden erkannt.

- Ohne Kontextverständnis wird das Feedback fälschlicherweise als positiv klassifiziert, obwohl es ironisch gemeint ist.

Regelbasierte Sentiment-Analyse: Zynisches Kundenfeedback

Kundenfeedback: „Es ist immer so wunderbar, wenn der Kaffee so lauwarm serviert wird, dass ich meine Hände kaum aufwärmen kann.“

Regelbasierte Klassifikation:

- Wörter wie „wunderbar“ werden als positive Indikatoren identifiziert.

- Das Feedback könnte irrtümlicherweise als positiv klassifiziert werden, da die zynische Bedeutung des Kontexts nicht erfasst wird.

Regelbasierte Sentiment-Analyse: Sarkastisches Kundenfeedback

Kundenfeedback: „Was für eine Freude, dass mein Espresso so stark verdünnt war, dass ich fast dachte, es wäre Wasser.“

Regelbasierte Klassifikation:

- Das Wort „Freude“ wird normalerweise positiv bewertet.

- Ohne die Fähigkeit, Sarkasmus zu erkennen, könnte das System dieses Feedback als positiv einstufen, obwohl es tatsächlich negativ ist.

In allen vier Beispielen würde ein lexikonbasierter Ansatz ähnliche Ergebnisse liefern wie ein regelbasierter Ansatz. Beide Methoden sind gut darin, direkte sentimentale Ausdrücke zu erkennen, stoßen aber an ihre Grenzen, wenn es um Ironie, Sarkasmus oder Zynismus geht. Diese komplexen sprachlichen Nuancen erfordern ein tieferes Verständnis des Kontexts, den einfache lexikon- oder regelbasierte Ansätze nicht leisten können. Moderne Methoden des maschinellen Lernens, die auf komplexeren NLP-Techniken basieren, sind in der Lage, solche Feinheiten besser zu erkennen und zu interpretieren.

Herausforderungen und Grenzen

Trotz ihrer Effektivität bei klaren Ausdrücken emotionalen Inhalts, sehen sich regelbasierte Systeme Herausforderungen gegenüber, wenn es um subtilere Kontexte oder Ironie geht. Einzelne Worte können oft mehrdeutig sein, und ohne Kontext ist es schwierig, die korrekte Stimmung zu erkennen. Forschungsarbeiten, wie etwa die im Journal PLOS ONE veröffentlichte Studie, adressieren diese Herausforderungen und suchen nach Wegen, um die Genauigkeit regelbasierter Sentiment-Analysen zu verbessern.

Wissenschaftliche Perspektive und Entwicklung

Die wissenschaftliche Forschung ist kontinuierlich bemüht, die Leistung der regelbasierten Sentiment-Analyse zu erweitern, wie in Studien und Veröffentlichungen auf Plattformen wie ScienceDirect oder in Dissertationen wie der von Herrn Pyshchyk an der Hochschule Ruhr West dargestellt ist. Es geht darum, komplexere Regeln zu entwickeln, die Idiome, Sarkasmus und kontextabhängige Bedeutungen besser erfassen können.

Zusammenfassung und Ausblick

Regelbasierte Ansätze bieten in der Sentiment-Analyse eine solide Grundlage zur Auswertung von Texten im Hinblick auf die darin ausgedrückte Stimmung. Obwohl diese Methoden ihre Limitationen haben, sind sie ein wichtiger Bestandteil eines umfassenden Portfolios an Analysewerkzeugen für NLP-Aufgaben und bleiben ein aktives Forschungsfeld mit erheblichem Entwicklungspotenzial.

Für die Zukunft zeichnet sich ab, dass regelbasierte Systeme zunehmend mit maschinellen Lernmethoden kombiniert werden, um die Genauigkeit und Anpassungsfähigkeit von Sentiment-Analysen weiter zu steigern. Plattformen wie AWS, Elastic und Taus bieten bereits fortschrittliche Analysewerkzeuge an, die aufzeigen, wie die Integration von KI und regelbasierten Ansätzen das Verständnis menschlicher Emotionen in Textform erleichtern könnte.

Durch die fortlaufende Erforschung und Weiterentwicklung der Methoden stellt die regelbasierte Sentiment-Analyse sicher, dass Unternehmen und Organisationen weiterhin tiefe Einblicke in das Meinungsbild ihrer Kunden und Nutzer erhalten können, um darauf aufbauend ihre Produkte und Dienstleistungen zu verbessern.

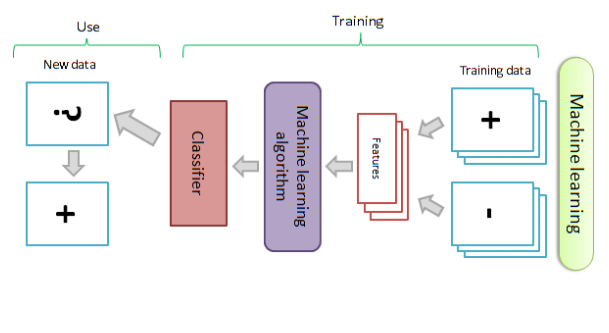

Automatische Lernmethoden in der Sentiment-Analyse

Durch den Einsatz automatischer Lernmethoden, insbesondere im Bereich des maschinellen Lernens (Machine Learning, ML) und der natürlichen Sprachverarbeitung (Natural Language Processing, NLP), hat sich die Effizienz und Genauigkeit der Sentiment-Analyse wesentlich verbessert. Dieses Unterkapitel beleuchtet die fortgeschrittenen Techniken und Algorithmen, die in den automatischen Lernmethoden der Sentiment-Analyse zur Anwendung kommen, untermauert durch aktuelle Literatur und Forschungsarbeit.

Grundlagen der automatischen Sentiment-Analyse

Die Sentiment-Analyse mittels automatischer Lernmethoden setzt auf Algorithmen, die aus großen Mengen an Textdaten lernen, um die Polarität (positiv, neutral, negativ) oder emotionale Färbung von Wörtern und Phrasen zu erkennen. Dazu bildet sie ein wichtiges Werkzeug für Unternehmen, um Einsichten aus Kundenfeedback, sozialen Medien und anderen textbasierten Kommunikationsmitteln zu gewinnen.

Maschinelles Lernen in der Sentiment-Analyse

Unterschiedliche Arten des maschinellen Lernens, wie überwachtes (supervised), unüberwachtes (unsupervised) und teilüberwachtes (semi-supervised) Lernen, sind grundlegend für moderne Sentiment-Analyse-Systeme. Überwachtes Lernen erfordert eine große Menge annotierter Trainingsdaten, wobei das Modell lernt, Sentiments basierend auf vordefinierten Kategorien zu klassifizieren. Im Gegensatz dazu versucht das unüberwachte Lernen, Muster in den Daten ohne vorherige Beschriftung zu identifizieren. Teilüberwachtes Lernen kombiniert beide Ansätze, um von einer kleinen Menge annotierter Daten und einer großen Menge nicht annotierter Daten zu profitieren.

Textanalyse und NLP-Techniken

Die Verarbeitung natürlicher Sprache und Textanalyse sind zentrale Bestandteile der Sentiment-Analyse. Komplexe NLP-Techniken wie Tokenisierung, Stemming, Lemmatisierung und Part-of-Speech-Tagging werden eingesetzt, um Texte in eine Form zu bringen, die von maschinellen Lernmodellen verarbeitet werden kann. Weiterhin spielen die Erkennung von Entitäten, Themenmodellierung und Syntaxanalyse eine entscheidende Rolle.

Algorithmen und Modelle der Sentiment Classifications

In der Sentiment-Analyse kommen diverse Algorithmen und Modelle zum Einsatz, die sich in ihrer Methodik und Komplexität unterscheiden. Jeder dieser Ansätze hat spezifische Stärken und eignet sich für verschiedene Aspekte der Textanalyse.

Entscheidungsbaum-Klassifikatoren (Decision Tree Classifier) sind eine Form von überwachtem Lernen, die Modellierung von Entscheidungsregeln ermöglichen. Sie arbeiten durch das Aufstellen einer Reihe von Fragen, basierend auf denen ein Text als positiv, negativ oder neutral klassifiziert wird.

Lineare Klassifikatoren hingegen, zu denen Logistic Regression (LR) und Support Vector Machines (SVM) gehören, verwenden mathematische Funktionen, um Datenpunkte in einem hochdimensionalen Raum zu trennen. LR schätzt die Wahrscheinlichkeit, dass eine Instanz zu einer Klasse gehört, während SVMs eine Grenze zwischen Klassen ziehen, die so weit wie möglich von den nächsten Datenpunkten jeder Klasse entfernt ist.

Neuronale Netzwerke sind leistungsfähige Modelle des Deep Learning, die besonders gut darin sind, komplexe Muster in großen Datensätzen zu erkennen:

- Recurrent Neural Networks (RNNs) können die Reihenfolge und Sequenz in den Daten berücksichtigen, was für die Analyse von Sätzen und längeren Texten entscheidend ist.

- Convolutional Neural Networks (CNNs) sind vorrangig aus dem Bereich der Bildverarbeitung bekannt, aber auch im NLP für die Erkennung lokaler und positioneller Muster im Text nützlich.

- Long Short-Term Memory networks (LSTMs) und Bi-directional LSTMs (Bi-LSTMs) sind spezielle Formen von RNNs, die besser mit dem Problem des langfristigen Gedächtnisses (long-term dependencies) umgehen können.

- Transformer Networks, wie BERT oder GPT, verwenden Attention-Mechanismen, um die Beziehung zwischen allen Wörtern in einem Text zu berücksichtigen und ermöglichen es, den Kontext auf eine Weise zu erfassen, die weit über die Fähigkeiten einfacher RNNs oder CNNs hinausgeht.

Regelbasierte Klassifikatoren (Rule Based Classifier) nutzen festgelegte linguistische Regeln, um die Stimmung auf Basis von Wortkombinationen und Satzstrukturen zu identifizieren.

Probabilistische Klassifikatoren beziehen Wahrscheinlichkeitsmodelle mit ein, wie:

- Multinomiale Naive Bayes (NB), die auf der Annahme basieren, dass die Merkmale (Wörter) in den Daten unabhängig voneinander sind, was eine schnelle Klassifizierung ermöglicht.

- Maximum Entropy-Modelle, die versuchen, die Wahrscheinlichkeitsverteilung zu finden, die am besten zu den Trainingsdaten passt, ohne weitere Annahmen zu treffen.

- Bayesian Networks, die Wahrscheinlichkeiten auf Basis von Abhängigkeiten zwischen Variablen modellieren.

Schließlich gibt es noch den K-Nearest-Neighbor (K-NN), einen algorithmischen Ansatz, der Klassifizierungen auf der Basis der am meisten ähnlichen Trainingsbeispiele vornimmt.

Diese Algorithmen bilden das Rückgrat moderner Sentiment-Analyse-Systeme und werden je nach Anforderung und Beschaffenheit der Daten ausgewählt.

Beispiele

Um zu verstehen, wie verschiedene maschinelle Lernansätze – speziell Naive Bayes, logistische Regression, Support Vector Machines (SVM), Deep Learning und kontextuelle Modelle – die vier genannten Beispiele der Sentiment-Analyse (normales, ironisches, zynisches und sarkastisches Kundenfeedback) behandeln würden, müssen wir ihre Funktionsweisen und ihre Fähigkeiten im Umgang mit komplexen sprachlichen Merkmalen betrachten.

Naive Bayes

Naive Bayes ist ein einfaches Wahrscheinlichkeitsmodell, das auf dem Bayesschen Theorem basiert und die Unabhängigkeit zwischen den Merkmalen annimmt. Es ist effektiv für direkte sentimentale Ausdrücke.

- Normales Feedback: Würde effektiv als positiv klassifiziert, da positive Wörter wie „sehr zufrieden“ und „hervorragend“ erkannt werden.

- Ironisches/Zynisches/Sarkastisches Feedback: Könnte Schwierigkeiten haben, die wahre Bedeutung zu erkennen, da Naive Bayes nicht die Fähigkeit hat, Kontext und sprachliche Nuancen zu berücksichtigen.

Logistische Regression

Logistische Regression ist ein statistisches Modell, das Wahrscheinlichkeiten verwendet, um Klassenzugehörigkeiten vorherzusagen. Es kann etwas besser als Naive Bayes mit Kontext umgehen, aber bleibt begrenzt in der Erkennung von Ironie und Sarkasmus.

- Normales Feedback: Würde wahrscheinlich korrekt als positiv klassifiziert.

- Ironisches/Zynisches/Sarkastisches Feedback: Während es besser als Naive Bayes abschneiden könnte, ist es unwahrscheinlich, dass es ohne spezifisches Training oder zusätzliche Feature-Engineering-Techniken Ironie und Sarkasmus effektiv erkennt.

Support Vector Machines (SVM)

SVM ist ein leistungsstarker Klassifikator, der eine Entscheidungsgrenze zwischen verschiedenen Klassen findet. Es kann komplexere Muster erkennen als Naive Bayes oder logistische Regression.

- Normales Feedback: SVM würde dies wahrscheinlich korrekt als positiv klassifizieren.

- Ironisches/Zynisches/Sarkastisches Feedback: SVM könnte besser abschneiden als einfacher Naive Bayes oder logistische Regression, insbesondere wenn es mit Features trainiert wird, die Kontext und sprachliche Nuancen einfangen.

Deep Learning

Deep Learning Modelle, insbesondere solche, die neuronale Netzwerke verwenden, sind fähig, komplexere Muster und Beziehungen in Daten zu erkennen.

- Normales Feedback: Wird mit hoher Wahrscheinlichkeit korrekt klassifiziert.

- Ironisches/Zynisches/Sarkastisches Feedback: Deep Learning Modelle sind wahrscheinlich effektiver in der Erkennung von Ironie und Sarkasmus, besonders wenn sie mit einem großen und diversifizierten Trainingsdatensatz trainiert werden, der diese sprachlichen Nuancen einschließt.

Zusammenfassung

Während traditionelle maschinelle Lernmodelle wie Naive Bayes, logistische Regression und SVM gewisse Einschränkungen bei der Erkennung von Ironie, Sarkasmus und Zynismus aufweisen, bieten fortgeschrittene Deep Learning und kontextuelle Modelle eine deutlich verbesserte Fähigkeit, diese komplexen sprachlichen Ausdrücke zu interpretieren. Die Leistungsfähigkeit dieser Modelle hängt jedoch stark von der Qualität und Vielfalt des Trainingsdatensatzes sowie vom Grad des Feature-Engineerings ab. Kontextuelle Modelle, die auf umfangreichen Datensätzen trainiert wurden, sind in der Lage, subtile Nuancen und Kontext in der Sprache zu erfassen, was sie zu den fortschrittlichsten Tools in der Sentiment-Analyse macht.

Herausforderungen und aktuelle Forschung

Trotz großer Fortschritte gibt es in der automatisierten Sentiment-Analyse weiterhin Herausforderungen wie Ironie, Slang, Idiome oder Kontextabhängigkeit. Aktuelle Forschungen konzentrieren sich unter anderem auf kontextuelle Modelle, wie sie beispielsweise in BERT (Bidirectional Encoder Representations from Transformers) und GPT (Generative Pretrained Transformer) zu finden sind, die eine noch tiefere semantische Verständnisfähigkeit ermöglichen.

Fazit

Computational linguistics, machine learning, und NLP weiterhin die Grenzen der Sentiment-Analyse durch fortgeschrittene Modelle und Techniken erweitern. Durch den gezielten Einsatz dieser Methoden können Unternehmen und Wissenschaftler tiefere Einblicke in die Meinungen und Gefühle von Menschen gewinnen, was in einer breiten Palette von Anwendungen, von der Marktanalyse bis hin zur politischen Meinungsforschung, von hoher Bedeutung ist.

Hybride Modelle in der Sentiment-Analyse

In der Sentiment-Analyse haben sich verschiedene Methoden etabliert, die grundsätzlich in zwei Hauptgruppen (die gerade beschrieben wurden) eingeteilt werden können: maschinenlernbasierte (ML) Ansätze und regelbasierte bzw. lexikonbasierte (LB) Ansätze. Maschinenlernmethoden nutzen klassifizierende Algorithmen, um Stimmungen aus Texten zu erkennen, während lexikonbasierte Ansätze Listen von wertgeladenen Wörtern verwenden und anhand deren Präsenz im Text eine Stimmung identifizieren.

Hybride Modelle kombinieren sowohl ML- als auch LB-Ansätze, um von den Stärken beider Methoden zu profitieren und ihre Nachteile auszugleichen. Sie sind Gegenstand vieler Studien und technischer Berichte, einschließlich solcher, die von Forschungseinrichtungen wie Hewlett-Packard oder in Journalen wie dem Journal of Big Data und anderen wissenschaftlichen Publikationen veröffentlicht wurden.

Die Vorteile hybrider Modelle liegen auf der Hand: Sie können die fehlende Kontextsensitivität von LB-Methoden durch das Erlernen von Mustern mittels ML überwinden. Gleichzeitig können sie die Schwierigkeit von ML-Methoden, Sarkasmus, Ironie oder kontextuelle Nuancen zu erfassen, durch die Einbeziehung von lexikonbasierten Techniken angehen. Viele Studien, wie die von der IEEE oder MDPI veröffentlichten, zeigen, dass hybride Modelle die Genauigkeit der Sentiment-Analyse signifikant verbessern können.

Ein weiterer Vorteil hybrider Modelle, der in der Forschung hervorgehoben wird, ist die Möglichkeit zur Individualisierung. Indem man Muster aus ML mit spezifischen, domänengebundenen LB-Ansätzen kombiniert, kann man Modelle schaffen, die auf den spezifischen Kontext und das spezifische Vokabular eines Themas oder einer Branche abgestimmt sind.

Ein Beispiel für die Anwendung hybrider Modelle ist die Analyse von Kundenfeedback in Echtzeit, um einen umfassenden Blick auf Kundenmeinungen zu erhalten, wie es Plattformen wie Sprinklr ermöglichen. Durch die Kombination von quantitativen Daten aus ML-Analysen mit qualitativen Erkenntnissen aus LB-Verfahren können Unternehmen nuancierter auf Kundenstimmungen reagieren.

Die Herausforderung bei der Entwicklung und Implementierung hybrider Modelle liegt darin, die richtige Balance zwischen ML und LB Methoden zu finden, wie auch die Berichte von Hindawi oder von de Gruyter diskutieren. Es ist entscheidend, den Gesamtkontext, die spezifischen Anforderungen und die verfügbaren Ressourcen zu berücksichtigen, um eine maßgeschneiderte, effektive Hybridlösung zu schaffen.

Abschließend, während reine ML- oder LB-Modelle ihre eigenen Vorteile aufweisen, bieten hybride Modelle eine vielversprechende Alternative, um die vielfältigen und komplexen Aspekte der menschlichen Sprache in der Sentiment-Analyse zu berücksichtigen. Durch kontinuierliche Forschung und Entwicklung sowie den Einsatz fortgeschrittener Algorithmen und leistungsfähigerer Computer wird erwartet, dass sich die Leistungsfähigkeit hybrider Modelle in der Sentiment-Analyse weiter verbessern wird.

Andere Ansätze

Transfer Learning und Aspect-Based Ansätze sind innovative Methoden in der Sentiment-Analyse, die jeweils einzigartige Vorteile bieten.

Der Ansatz des Transferlernens (Transfer Learning) basiert auf dem Konzept der Übertragung von Wissen, das ein Modell durch das Training auf einer bestimmten Aufgabe erworben hat, auf eine neue, jedoch verwandte Aufgabe. Diese Methodik ist in der Sentiment-Analyse besonders nützlich, da sie es ermöglicht, fortschrittliche Modelle, die auf umfangreichen und generischen Datensätzen trainiert wurden, auf spezifische Sentiment-Analyse-Aufgaben anzuwenden. Modelle wie BERT oder GPT, die umfassende Sprachrepräsentationen während des Trainingsprozesses erlernen, können ihre Fähigkeiten nutzen, um auch bei einer begrenzten Verfügbarkeit von spezifischen Trainingsdaten effektiv zu sein. Diese Modelle, oft auch als kontextuelle Modelle bezeichnet, heben sich durch ihre Fähigkeit hervor, den gesamten Kontext eines Wortes innerhalb eines Satzes zu berücksichtigen. Sie gehen damit über die Analyse unmittelbar benachbarter Wörter hinaus und nutzen Attention- oder Self-Attention-Mechanismen, um die Beziehungen zwischen Wörtern über längere Distanzen im Text hinweg zu erfassen. Solche kontextuellen Modelle sind in der Lage, subtile Nuancen und komplexe sprachliche Phänomene wie Ironie und Sarkasmus zu erkennen, was sie für die Sentiment-Analyse besonders wertvoll macht. Die Diskussion und das Verständnis kontextueller Modelle tragen maßgeblich dazu bei, die Algorithmen und Modelle der Sentiment-Klassifikation in der aktuellen Forschung und Anwendung zu erweitern und zu aktualisieren.

Aspect-Based Sentiment Analysis (ABSA): ABSA konzentriert sich auf die Identifizierung von Meinungen, die sich auf spezifische Aspekte oder Merkmale eines Produkts oder Dienstes beziehen. Anstelle einer allgemeinen Sentiment-Bewertung analysiert ABSA, wie Kunden einzelne Aspekte wie die Qualität des Produkts, die Effizienz des Services oder die Benutzerfreundlichkeit einer Software fühlen. Dies ermöglicht Unternehmen, gezielte Einblicke zu gewinnen und spezifische Bereiche für Verbesserungen zu identifizieren. Beispielsweise könnte ein ABSA-Modell in Hotelbewertungen die Sentiments bezüglich Sauberkeit, Komfort der Betten oder Freundlichkeit des Personals separat analysieren und somit detaillierte Informationen für das Management bereitstellen.

Beide Ansätze erweitern die Fähigkeiten der traditionellen Sentiment-Analyse und ermöglichen eine feinere und spezifischere Analyse von Textdaten, die für präzisere Geschäftsentscheidungen unerlässlich sind.

Technologien und Tools für die Sentiment-Analyse

NLP-Bibliotheken und Frameworks für die Sentiment-Analyse

Die Verarbeitung Natürlicher Sprache (Natural Language Processing, NLP) ist ein zentraler Bestandteil der Sentiment-Analyse und spielt eine entscheidende Rolle bei der Interpretation und Bewertung von Textdaten. Verschiedene NLP-Bibliotheken und Frameworks bieten Entwicklern und Forschern leistungsstarke Werkzeuge, um Stimmungen (Sentiments) in großen Mengen von Textdaten zu erkennen und zu analysieren. In diesem Unterkapitel werden wir einige der beliebtesten und effektivsten NLP-Bibliotheken und Frameworks diskutieren, die für die Sentiment-Analyse verwendet werden können.

Open-Source NLP-Bibliotheken

Die Open-Source-Gemeinschaft hat einige hochwertige Bibliotheken bereitgestellt, die für die Sentiment-Analyse eingesetzt werden können. Diese Bibliotheken sind meist kostenlos, verfügen über eine aktive Entwicklergemeinde und werden ständig weiterentwickelt.

- NLTK (Natural Language Toolkit): NLTK ist eine der führenden Plattformen für die Verarbeitung von natürlicher Sprache in Python. Sie bietet einfache Schnittstellen zu über 50 Korpora und lexikalischen Ressourcen wie WordNet sowie eine Suite von Textverarbeitungs-Bibliotheken für Klassifikation, Tokenisierung, Stemming, Tagging, Parsing und semantische Argumentation.

- spaCy: spaCy ist bekannt für seine Geschwindigkeit und Effizienz und bietet vortrainierte statistische Modelle und Wortvektoren. Es wird häufig bei produktionsreifen Anwendungen eingesetzt und verfügt über eine reichhaltige Entwicklererfahrung.

- TextBlob: TextBlob ist eine weitere einfache Bibliothek für die Verarbeitung von Textdaten in Python. Es ist besonders benutzerfreundlich, was es zu einer guten Wahl für den Einstieg in NLP und Sentiment-Analyse macht.

- Stanford CoreNLP: Diese Java-basierte Bibliothek bietet eine breite Palette von NLP-Tools und ist für ihre Genauigkeit bekannt. Sie kann auch aus anderen Programmiersprachen wie Python genutzt werden.

- VADER (Valence Aware Dictionary and sEntiment Reasoner): VADER ist eine lexikon- und regelbasierte Sentiment-Analyse-Bibliothek, die speziell für soziale Medien und Texte mit Slangs, Emojis und Akronymen entwickelt wurde.

| Bibliothek/Framework | Unterstützte Methoden der Sentiment-Analyse |

|---|---|

| NLTK | Lexikonbasiert (z.B. mit Sentiment-Lexika), Unterstützung für diverse ML-Algorithmen wie Naive Bayes, Entscheidungsbäume, bietet auch Tools für regelbasierte Analyse |

| spaCy | Integration mit ML-Frameworks (z.B. scikit-learn), bietet Entity Recognition und Dependency Parsing, keine spezifischen Sentiment-Analyse-Tools out-of-the-box |

| TextBlob | Einfache lexikonbasierte Sentiment-Analyse, Integration mit Naive Bayes und Decision Trees für maßgeschneiderte Sentiment-Analyse |

| Stanford CoreNLP | Umfangreiche NLP-Tools, inklusive regelbasierter Ansätze, ML-basierte Methoden (z.B. Support Vector Machines) über Integration mit anderen Bibliotheken |

| VADER | Spezialisiert auf lexikonbasierte Sentiment-Analyse, optimiert für soziale Medien und Texte mit Slang, verwendet eine Kombination aus lexikalischen Heuristiken und Regeln |

Kommerzielle NLP-Produkte und API-basierte Lösungen

Neben den Open-Source-Bibliotheken gibt es auch kommerzielle Produkte, die meist cloud-basierte NLP-Dienste bereitstellen. Diese sind oft benutzerfreundlich und bieten leistungsstarke APIs für verschiedene NLP-Aufgaben, einschließlich Sentiment-Analyse.

- Google Cloud Natural Language API: Dieser Dienst von Google bietet leistungsstarke maschinelle Lernfunktionen, um die Struktur und Bedeutung von Text zu verstehen. Er unterstützt mehrere Sprachen und kann Emotionen und Meinungen in Texten identifizieren.

- Amazon Comprehend: Amazons Comprehend-Dienst erkundet und klassifiziert Textdaten, um Kunden dabei zu helfen, besser zu verstehen, was ihre Daten vermitteln. Es verwendet maschinelles Lernen, um Muster und Themen in unstrukturierten Daten zu identifizieren.

- IBM Watson Natural Language Understanding: IBMs Service kann Emotionen und Stimmungen in Textinhalten erkennen und liefert tiefe Einblicke in die öffentliche Meinung und das Kundensentiment.

- Microsoft Azure AI Language Service: Microsoft Azure AI Language Service bietet einen Sentimentanalyse-Dienst an, der auf der Azure-Cloud-Plattform basiert. Dieser Dienst ist Teil eines größeren Angebots an kognitiven Diensten, die sprachliche, visuelle und Entscheidungsfunktionen umfassen und in bestehende Applikationen integriert werden können.

- MonkeyLearn: MonkeyLearn bietet benutzerdefinierte Sentiment-Analyse-Modelle, die für spezifische Anforderungen und Branchen trainiert werden können, und ist einfach in vorhandene Infrastrukturen zu integrieren.

| API-Lösung | Unterstützte Methoden der Sentiment-Analyse |

|---|---|

| Google Cloud Natural Language | Maschinelles Lernen für Strukturanalyse, mehrsprachige Sentiment-Erkennung |

| Amazon Comprehend | ML-basierte Mustererkennung, Klassifizierung von Textdaten, Erkennung von Themen |

| IBM Watson Natural Language | Erkennung von Emotionen und Stimmungen, tiefgehende Analyse öffentlicher Meinungen |

| Microsoft Azure AI Language | ML-basierte Sentimentanalyse, Teil eines umfangreicheren Angebots an kognitiven Diensten |

| MonkeyLearn | Benutzerdefinierte ML-Modelle für spezifische Branchen, einfache Integration |

Python-Bibliotheken und Frameworks

Python gilt als die führende Sprache im Bereich NLP aufgrund seiner Einfachheit und der großen Zahl an Bibliotheken. Hier sind einige Python-spezifische Bibliotheken und Frameworks:

- scikit-learn: Ein breit einsetzbares Machine-Learning-Toolkit, mit dem auch Feature-Engineering und -Extraktion für Textklassifikation vorgenommen werden können.

- Gensim: Speziell für „Topic Modeling“ und „Document Similarity“ entwickelt, werden in Gensim auch Funktionen für Sentiment-Analyse unterstützt.

- Keras/TensorFlow/PyTorch: Diese fortgeschrittenen Machine-Learning- und Deep-Learning-Bibliotheken werden für komplexere Sentiment-Analyse-Modelle benötigt, die auf neuronalen Netzwerken basieren.

| Python-Bibliothek/Framework | Unterstützte Methoden der Sentiment-Analyse |

|---|---|

| scikit-learn | Unterstützt ML-Algorithmen für Textklassifikation, Feature-Engineering und -Extraktion |

| Gensim | Topic Modeling, Document Similarity, unterstützt auch Sentiment-Analyse Funktionen |

| Keras/TensorFlow/PyTorch | Fortgeschrittene Deep Learning-Frameworks, geeignet für komplexe neuronale Netzwerkmodelle in der Sentiment-Analyse |

Akademische Recherche und Diskussionen

Wissenschaftliche Publikationen und Foren wie Quora, ScienceDirect, IEEE Xplore und Springer bieten tiefergehende Einblicke in die Theorien hinter Sentiment-Analyse, aktuelle Forschungen und Entwicklungen in diesem Bereich sowie Bewertungen verschiedener Ansätze und Tools.

Die Sentiment-Analyse ist ein lebendiger und sich schnell entwickelnder Bereich, getrieben durch den Wunsch nach besseren Einblicken in die Meinungen der Menschen. Die breite Palette an verfügbaren Tools – von Fertigprodukten bis hin zu anpassbaren Lösungen – bietet Unternehmen und Forschern eine Vielzahl von Möglichkeiten, um die Stimmungen und Meinungen in großen Textmengen zu analysieren. Unabhängig von der gewählten Methode oder Technologie ist es entscheidend, das Tool zu finden, das am besten zu den spezifischen Anforderungen und Daten passt.

Sentiment-Analyse-Software

Die Sentiment-Analyse ist ein Bereich des Natural Language Processing (NLP), der sich mit der Identifizierung und Kategorisierung von Meinungen in Text umfasst, um zu verstehen, ob die Stimmung einer Aussage positiv, neutral oder negativ ist. Dank fortschrittlicher Algorithmen und des zunehmenden Bedarfs an Datenanalytik in den sozialen Medien, Kundenfeedback und anderen Arten der digitalen Kommunikation hat sich ein vielfältiges Angebot an Sentiment-Analyse-Tools entwickelt. Diese Tools nutzen sowohl maschinelles Lernen als auch linguistische Ansätze, um den Ton und die subjektiven Informationen in großen Mengen von Text effizient zu analysieren.

Einige der bekanntesten Sentiment-Analyse-Softwares und deren Eigenschaften werden in der folgenden Ausführung präsentiert.

Beispielhafte Tools und ihre Funktionen

Machine Learning-basierte Analyseplattformen

MonkeyLearn ist eine bekannte Plattform für Textanalyse, die umfangreiche Sentiment-Analyse-Tools bietet. Es ermöglicht Benutzern, mithilfe von maschinellem Lernen maßgeschneiderte Modelle zu trainieren, die auf die spezifischen Anforderungen und Datenstrukturen abgestimmt sind. Die Stärke von MonkeyLearn liegt in seiner benutzerfreundlichen Schnittstelle und der Fähigkeit, schnell und effektiv Stimmungen aus Kundenbewertungen, Umfragen und anderen Textquellen zu extrahieren.

Social Media Sentiment-Analyse-Tools

Brand24 bietet eine Echtzeitanalyse von Online-Gesprächen, einschließlich Überwachung der Sozialen Medien, was es für Marken einfach macht, nicht nur Erwähnungen ihres Namens zu verfolgen, sondern auch die Stimmung dieser Erwähnungen zu analysieren. Es liefert Insights zu Kundenstimmungen und hilft bei der Krisenvermeidung, indem negative Kommentare schnell erkannt werden.

Customer Review Analysis

SOCi Reviews ist ein Produkt der SOCi-Plattform, das speziell darauf ausgerichtet ist, Customer Reviews zu sammeln und zu analysieren. Mit Fokus auf lokale Unternehmen und deren Ratings ermöglicht SOCi Reviews eine granulare Analyse von Kundenfeedback, was für Unternehmen, die lokale SEO priorisieren, besonders wertvoll ist.

Vergleiche von Sentiment-Analyse-Tools

Auf Investiga.ai oder Gartner finden sich umfangreiche Analysen und Vergleiche verschiedener Sentiment-Analyse-Tools. Diese bieten einen guten Überblick über die Stärken und Schwächen verschiedener Ansätze und Produkte, indem sie Faktoren wie Genauigkeit, Umfang der Sprachenunterstützung, Integrationsmöglichkeiten und Anpassungsfähigkeit berücksichtigen.

Cloud-basierte Sentiment-Analyse-Dienste

Die oben beschriebenen API-Dienste sind Teil eines größeren Angebots an kognitiven Diensten, die sprachliche, visuelle und Entscheidungsfunktionen umfassen und in bestehende Applikationen integriert werden können. Daneben existieren auch noch firmenspezifische Analyse-Dienstleistungen. Hitachi’s Sentiment Analysis ist ein Beispiel dafür, wie spezialisierte IT-Dienstleistungsunternehmen ihre eigenen proprietären Sentiment-Analyse-Tools entwickeln. Diese sind oft auf spezifische Branchenanforderungen zugeschnitten und bieten individuelle Lösungen für große Unternehmen an.

Schlüsselaspekte der Sentiment-Analyse-Software

Wichtig bei der Wahl einer Sentiment-Analyse-Software sind unter anderem folgende Elemente:

- Analysegenauigkeit: Die Präzision, mit der das Tool die Stimmung von Text erfassen kann.

- Echtzeitverarbeitung: Für viele Anwendungen ist es entscheidend, dass die Sentiment-Analyse in Echtzeit erfolgt.

- Sprachunterstützung: Produkte, die mehrere Sprachen unterstützen, bieten einen breiteren Anwendungsbereich.

- Anpassungsfähigkeit: Die Fähigkeit der Software, auf spezifische Anforderungen eines Unternehmens oder Sektors zugeschnitten zu werden.

- Integrationen: Wie gut sich ein Tool in bestehende Systeme und Prozesse einbinden lässt.

- Preismodelle: Die Kosten können je nach Funktionsumfang, Nutzungsintensität und benötigter Skalierung stark variieren.

Fazit

Es gibt eine breite Palette an Sentiment-Analyse-Tools auf dem Markt, die sowohl für kleine Unternehmen als auch für große Konzerne passende Lösungen bieten. Die Wahl der richtigen Software hängt von den individuellen Bedürfnissen des Nutzers ab und sollte basierend auf Faktoren wie Genauigkeit, Sprachunterstützung, Anpassbarkeit und Kosten getroffen werden. Wissenschaftliche Forschung und Produktvergleiche von renommierten Unternehmen wie Gartner können bei dieser Entscheidung eine wichtige Hilfestellung bieten.

Cloud-Dienste und APIs im Detail

In den letzten Jahren haben sich die oben beschriebenen Cloud-Dienste und APIs als Schlüsseltechnologien für die Sentiment-Analyse etabliert, da sie eine einfache Integration und eine skalierbare Analyse in Echtzeit ermöglichen. In diesem Unterkapitel werden wir uns verschiedene Cloud-Plattformen und APIs ansehen, die für die Sentiment-Analyse genutzt werden können.

Google Cloud Natural Language API

Die Google Cloud Natural Language API ist eines der führenden Werkzeuge zur Sentiment-Analyse. Sie nutzt maschinelles Lernen, um Text zu analysieren und wertvolle Metadaten hinsichtlich Stimmung, Entitätenerkennung und Syntax zu extrahieren. Mit dieser API können Entwickler einfache Anfragen senden und die Analysen auf einer Skala von -1 (sehr negativ) bis +1 (sehr positiv) erhalten. Dies ermöglicht Unternehmen, die Stimmung ihrer Kunden schnell zu erfassen und entsprechend zu handeln. Die Kosten für die Nutzung der Google Cloud Natural Language API können je nach Volumen der Anfragen variieren, wodurch Unternehmen ihre Ausgaben je nach Bedarf skalieren können.

AWS Comprehend

Ähnlich wie Google bietet auch Amazon Web Services (AWS) mit AWS Comprehend ein mächtiges Tool für die Sentiment-Analyse. Comprehend verwendet ebenfalls maschinelles Lernen, um Muster und Zusammenhänge in Texten zu verstehen. Es erlaubt nicht nur die Erkennung von Sentiments, sondern auch die Identifizierung von Themen und Kategorisierung von Textdaten. Durch die nahtlose Integration mit anderen AWS-Diensten eignet sich Comprehend für Unternehmenslösungen, die eine umfassende Datenanalyseplattform benötigen.