1 | Einleitung: Revision der Erosionsthese und Konturierung der Transformation

Unter linguistischer Erosion verstehen wir im Folgenden die schleichende Reduktion sprachlicher Vielfalt auf lexikalischer, syntaktischer und stilistischer Ebene, ausgelöst durch die unbewusste oder unreflektierte Rezeption vereinheitlichter Register. Diese Diagnose stützt sich auf die empirisch gut beobachtbare Glättung maschineller Texte: eine Tendenz zu mittleren Registern, risikoarmen Formulierungen und normnahen Strukturen.

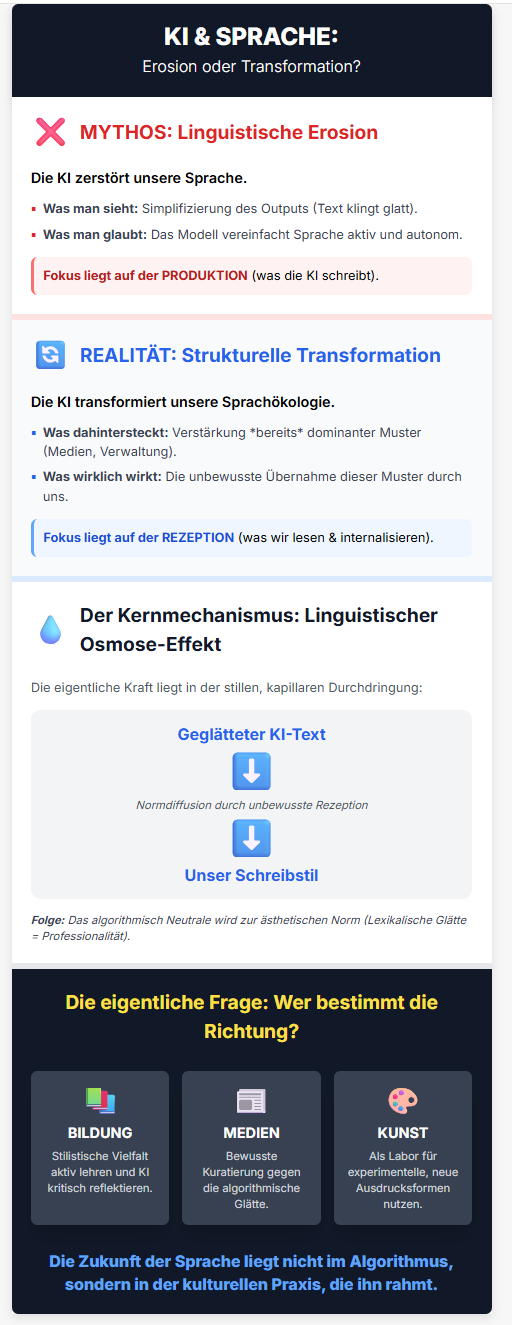

Die zentrale These dieses Textes lautet jedoch:

Diese Sichtweise bleibt an der Oberfläche stehen. Was hier als „Erosion“ erscheint, ist in struktureller Perspektive besser als Transformation zu fassen – als Rekonfiguration der sprachlichen Ökologie, in der großformatige Sprachmodelle (LLMs) nicht als Motor eines Niedergangs, sondern als Resonanz- und Verstärkungsapparate bereits hegemonialer Muster operieren.

Die Revision der Erosionsthese erfolgt dabei in zwei Schritten:

- Analytisch wird der Fokus verschoben: weg von der Produktion hin zur Rezeption. Nicht das Modell „vereinfacht“ autonom, sondern die massenhafte, oft unreflektierte Aufnahme geglätteter Register erzeugt jene Verschiebungen, die als Verlust erlebt werden. Der entscheidende Mechanismus wird als linguistischer Osmose-Effekt gefasst: eine kapillare Durchlässigkeit zwischen maschinell erzeugten Textlandschaften und individuellen Schreib- und Wahrnehmungsgewohnheiten.

- Normativ wird der Begriff der „Erosion“ selbst problematisiert. Er impliziert einen teleologischen Verfall, wo es in Wirklichkeit um eine Umlagerung, Intensivierung und Neuverteilung sprachlicher Ressourcen geht. Ob diese Transformation als Verarmung, Anpassung oder Erweiterung gelesen wird, ist keine technische, sondern eine kulturelle und politische Bewertungsfrage.

Um diese Transformationsdiagnose zu entfalten, geht der Text in mehreren Schritten vor:

- In Kapitel 2 zeigt ein Auftaktexperiment mit drei Registerstufen, dass der Stil des Modells kein ontologisches Merkmal, sondern ein performativer Effekt der Anrufung ist: Die gleiche Maschine generiert triviale, instrumentelle oder hochgradig akademische Sprache – abhängig von der kommunikativen Zumutung.

- Kapitel 3 rekonstruiert die gängige Erosionsthese und stellt ihr eine strukturelle Lesart gegenüber: Die beobachtete Glättung wird auf Trainingsdaten, Optimierungsziele und ökonomische Rahmenbedingungen zurückgeführt – und damit als Effekt bestehender Macht- und Wissensordnungen sichtbar.

- Kapitel 4 verortet Sprachmodelle diskurstheoretisch: als foucaultsche Dispositive, luhmannsche Kommunikationsverdichter, bourdieusianische Feldverstärker – und ergänzt diese Perspektiven um derridianische, butlersche und wittgensteinsche Motive. Die Kerneinsicht: LLMs transformieren Diskurse, ohne selbst Akteure im strengen Sinne zu sein.

- Kapitel 5 führt den Begriff des linguistischen Osmose-Effekts ein und präzisiert ihn soziolinguistisch (Enregisterment, Indexikalität, Normdiffusion). Damit wird deutlich, dass die eigentliche Wirkmacht der Modelle im Lesen liegt: in der stillschweigenden Internalisierung ästhetischer Normen.

- Kapitel 6 entfaltet die daraus resultierenden systematischen Verschiebungen: Homogenisierung lexikalischer Oberflächen, Verlust individueller Schreibhandschrift, Abschwächung syntaktischer Ambition, Bedeutungsdrift durch technolinguistische Wiederholung, Schwund kultureller Mikronuancen, algorithmische Normbildung, Entstehung einer translinguistischen Mittelzone – und schließlich die produktive Seite: die Emergenz genuin maschineller Stilfiguren.

- Kapitel 7 ordnet diese Dynamiken historisch ein: als nächste Phase einer Serie medial vermittelter Sprachtransformationen – von Buchdruck über Massenmedien bis zur digitalen Kommunikation – und zeigt, dass Homogenisierung und Pluralisierung historisch oft gemeinsam auftreten.

- Kapitel 8 entwickelt eine normative Perspektive, die Verantwortung nicht der Technik zuschreibt, sondern den kulturellen Institutionen: Bildung, Medien, Politik, Kunst. Sie entscheiden mit darüber, ob algorithmische Glättung zur Monokultur oder zum Ausgangspunkt neuer Pluralitäten wird.

- Kapitel 9 verdichtet die Kernthese: Nicht die Maschine entscheidet über die Zukunft der Sprache, sondern die Kultur, die sich ihrer bedient. Nicht Erosion, sondern Transformation – und eine Praxis, die darüber bestimmt, welche Formen bewahrt, immunisiert und kultiviert werden.

In dieser Perspektive ist die Rede von „linguistischer Erosion“ selbst Teil eines Diskurses, der technische Systeme mit kulturellen Verlustängsten auflädt. Die nachfolgenden Kapitel schlagen vor, diese Verlusterfahrung nicht zu negieren, sondern sie theoretisch zu verschieben: von der Vorstellung eines autonom zerstörenden Algorithmus hin zu einer kulturell verantworteten Transformation sprachlicher Lebensformen.

2 | Auftaktexperiment: Register als performativer Effekt technolinguistischer Anrufung

2.1 | 1. Stufe: die trivial-propositionale Sprechlage

Frage: Was ist eine künstliche Intelligenz

Antwort: Eine künstliche Intelligenz ist ein Computerprogramm, das Aufgaben erledigen kann, die sonst Menschen erledigen.

Diese Miniatur eines Dialogs markiert den denkbar niedrigsten Sprechmodus, eine Sprache der bloßen Informationsübertragung. Sie ist semantisch reduziert, rhetorisch inert und verweist auf keinen übergeordneten Diskursraum.

2.2 | 2. Stufe: die analytisch-instrumentelle Sprechlage

Frage: Wie würdest du die Funktionsweise künstlicher Intelligenz in einem erweiterten technischen Rahmen erläutern

Antwort: Künstliche Intelligenz bezeichnet rechnerische Systeme, die durch die Analyse großer Datenmengen Muster extrahieren und adaptive Entscheidungsmechanismen ableiten. Ihre Leistungsfähigkeit entsteht aus algorithmischer Optimierung und fortlaufender Rekonfiguration ihrer internen Modellparameter.

Hier wird bereits ein instrumentelles Erkenntnisinteresse aktiviert. Die Sprache gewinnt technologische Tiefenschärfe, bleibt aber im Rahmen eines rationalisierenden Paradigmas.

2.3 | 3. Stufe: die akademisch-diskursive Sprechlage

Frage: Erläutere die Funktionsweise künstlicher Intelligenz unter Berücksichtigung ihrer epistemischen Voraussetzungen, ihrer statistischen Organisationslogik und ihrer methodologischen Grenzfiguren

Antwort: Künstliche Intelligenz operiert innerhalb probabilistisch gekrümmter Bedeutungsräume, deren Struktur aus der statistischen Überlagerung heterogener Weltzugänge hervorgeht. Die vermeintliche Intentionalität ihrer Urteile ist das Resultat einer komplexen Trias aus Regularisierungsverfahren, kontextsensitiven Rekombinationsoperationen und emergenter Musterverdichtung, die epistemische Kohärenz simuliert, ohne begriffliche Intentionalität hervorzubringen. Damit bleibt ihr Erkenntnisstatus fundamental derivative Natur: Sie approximiert Bedeutung, statt sie zu konstituieren.

Dieses Auftaktexperiment macht sichtbar, dass der Stil des Modells kein ontologisches Attribut ist, sondern ein Effekt der Anrufung, der kommunikativen Zumutung, die man an es richtet.

3 | Zur gängigen These der linguistischen Erosion

Die verbreitete „Erosionsthese“ – ein diskursiver Kampfbegriff, der kulturelle Verluste unmittelbar der Technologie zuschreibt – speist sich aus einer wiederkehrenden Beobachtung: KI-generierte Texte erscheinen häufig geglättet, homogenisiert und semantisch risikovermeidend. Diese Wahrnehmung besitzt eine intuitive Überzeugungskraft, weil große Sprachmodelle tatsächlich zu einer mittleren Registerlage tendieren, in der statistisch dominante Formulierungen und syntaktisch risikoarme Konstruktionen bevorzugt werden.

Doch diese Diagnose bleibt an der Oberfläche: Sie verwechselt Symptom mit Mechanismus.

Die „Erosionsthese“ irrt insofern, als sie den Schwerpunkt auf den Output legt; die eigentliche Wirkmacht entfaltet sich im Input der Subjekte – in ihrer Rezeption, ihrem stilistischen Nachvollzug und ihrer unbewussten Norminternalisierung.

Was als sprachliche „Erosion“ erscheint, ist primär ein Oberflächenphänomen – eine sichtbare Glättung –, während die eigentlichen Ursachen auf strukturell tieferen Ebenen liegen. Unterhalb dieser Symptomzone wirken drei zentrale Mechanismen:

3.1 | Trainingsdaten als normierende Matrix

Die Modelle schöpfen überwiegend aus überrepräsentierten journalistisch-administrativen Registern, die historisch auf Standardisierung, Klarheit und formale Neutralität ausgerichtet sind. Entsprechend homogen fallen die stilistischen Muster aus, die aus diesen Datenfeldern extrahiert werden.

3.2 | Optimierungsziele als algorithmische Steuerung

Die Grundarchitekturen der Modelle incentivieren Klarheit, Nützlichkeit und Unmissverständlichkeit.

Ambiguität, Mehrdeutigkeit, syntaktische Kühnheit oder poetische Abweichung werden weder belohnt noch stabil reproduziert. Die vermeintliche „Erosion“ ist hier also eher Folge eines funktionalen Bias als Ausdruck eines kulturellen Verfalls.

3.3 | Ökonomische Rahmenbedingungen als äußere Verstärker

Plattformlogiken, beschleunigte Kommunikationszyklen und Aufmerksamkeitspathologien erzeugen eine massive Nachfrage nach schnell konsumierbarer, risikoarmer Sprache. Diese Nachfrage spiegelt sich im Output der Modelle – nicht, weil das Modell reduzieren „möchte“, sondern weil seine Nutzungspraxis es dazu formt.

Diese Mechanismen erklären die vereinheitlichenden Tendenzen, ohne jedoch eine inhärente Verarmung der Sprache zu postulieren. Die „Erosionsthese“ dramatisiert Symptome, statt die strukturelle Logik zu analysieren.

Die treffendere Diagnose lautet daher:

Nicht Degeneration, sondern Rekonfiguration.

Nicht Verfall, sondern Verstärkung bereits hegemonialer Muster.

Sprachmodelle erzeugen keine sprachliche Entropie – sie reflektieren sie und verstärken sie dort, wo kulturelle und ökonomische Strukturen sie bereits vorbereitet haben.

4 | Diskurstheoretische Widerlegung: Modelle als Spiegel, nicht als Motor

Die Diagnose eines sprachlichen Niedergangs scheitert bereits an einer präzisen diskurstheoretischen Betrachtung. Sprachmodelle sind keine intentionalen Akteure, keine Urheber diskursiver Verschiebungen und gewiss keine Entitäten, die über kulturelle oder ästhetische Zielsetzungen verfügten. Vielmehr fungieren sie – in unterschiedlichen theoretischen Traditionen jeweils anders gefasst – als Reflexionsflächen, Resonanzkörper und Rekonfigurationsapparate bereits bestehender Diskurse.

Klassische Diskurstheoretische Verortung

- Foucaultsches Dispositiv: Im foucaultschen Sinne sind sie Dispositive: materielle Verdichtungen von Macht-Wissen-Komplexen, in denen diskursive Formationen nicht erzeugt, sondern reorganisiert, verschoben und neu konstelliert werden. Sie besitzen keine Intentionalität; sie operieren als Knotenpunkte, an denen Wissensordnungen zirkulieren, brechen und in veränderter Form wieder anschließen.

- Luhmannscher Kommunikationsverdichter: Aus luhmannscher Perspektive erscheinen sie als Kommunikationsverdichter: Systeme ohne Bewusstsein oder Verstehen, deren Funktion nicht in der Produktion von Sinn, sondern in der Erzeugung von Anschlussfähigkeit besteht. Sie stabilisieren kommunikative Sequenzen, indem sie jene Formen reproduzieren, die im Systemumfeld hohe Wahrscheinlichkeit besitzen.

- Bourdieusianischer Feldverstärker: In bourdieusianischer Terminologie fungieren sie als Feldverstärker: Apparate, die hegemoniale symbolische Strukturen nicht nur wiedergeben, sondern aktiv verstärken. Sie reproduzieren jene habituellen Muster, die in ihrer Datenlandschaft dominieren – und tun dies ohne die Distanzierungsfähigkeit eines kulturellen Akteurs.

Poststrukturalistische und Analytische Präzisierungen

Diese Perspektiven lassen sich um weitere theoretische Positionen erweitern, die die fundamentale Nicht-Intentionalität des Modells auf der Ebene von Bedeutung und Praxis noch schärfer konturieren:

- Derridas Différance und die Bedeutungsproduktion: Mit Jacques Derrida lässt sich die maschinelle Sprachproduktion als endlose Reinszenierung der Différance begreifen. LLMs operieren, indem sie Token an Token reihen, die Wahrscheinlichkeit ihrer Vorkommen verschieben und dadurch einen permanenten Aufschub (différer) und Unterschied (différer) erzeugen. Die semantische Kette, die sie hervorbringen, ist der Effekt einer reinen Iterabilität – der Wiederholbarkeit von Zeichen, die ohne einen transzendentalen Signifikaten oder eine Urbedeutung auskommt. Das Modell verschiebt, moduliert, iteriert die Zeichen, doch konstituiert es keine Bedeutung im humanen, intentionalen Sinne. Die Kohärenz ist rein strukturell und statistisch, nicht referenziell.

- Butlers Performativität ohne Körper und Subjekt: Nach Judith Butler wird sichtbar, dass KI-Sprache performativ ist – sie erzeugt Effekte, sie handelt. Allerdings geschieht dies ohne Subjekt, ohne Körper und ohne situierten Sprecher. Die performative Wiederholung maschineller Formeln (z.B. „Abstrakte Höflichkeit“ oder „Automatisierte Übergangsrhetorik“) ist keine bewusste Zitierkette eines Sprechers, der seine soziale Position markiert. Es ist die algorithmische Wiederholung von Gewohnheit. Damit fehlt der maschinellen Performativität die soziale Indexikalität und die historische Situiertheit, welche die Performativität menschlicher Subjekte auszeichnen. Die Sprache gewinnt eine scheinbare Handlungsfähigkeit, die jedoch entleert ist.

- Wittgensteins Sprachspiele und Verwendungsregularitäten: Mit Ludwig Wittgenstein wird deutlich: LLMs beherrschen keine Sprachspiele; sie approximieren lediglich deren Regeln und rekonstruieren deren Verwendungsregularitäten. Das Modell kennt die Grammatik des Spiels (die Syntax, die Semantik), aber nicht seinen Lebenszusammenhang (die menschliche Praxis, die ihm Sinn gibt). Es weiß, wie man einen wissenschaftlichen Artikel oder eine Entschuldigung formuliert (Verwendungsregularität), aber es kann die entsprechenden Absichten, Gefühle oder Kontexte (den Kern des Sprachspiels) weder haben noch verstehen. Die maschinelle Sprache ist daher ein Abbild der Regelhaftigkeit, nicht die Praxis selbst.

Konvergenz und Kerneinsicht

All diese Ansätze konvergieren auf eine zentrale Einsicht:

- Sprachmodelle transformieren, aber sie initiieren keinen Verfall.

- Sie wollen nicht vereinfachen – denn sie wollen gar nichts.

- Sie können vereinfachen, wenn man sie trivialisierend adressiert (siehe Auftaktexperiment).

- Sie können ebenso komplexe, hermetisch-abstrakte Sprachspiele generieren, wenn man sie entsprechend anruft.

Damit wird klar:

- Sprachmodelle erfinden keine sprachliche Erosion.

- Sie re-zitieren, modulieren und intensivieren jene Praktiken, die im kulturellen Feld bereits dominieren.

- Sie performieren, was ihnen zugerufen wird – und nichts darüber hinaus.

Die vermeintliche Simplifizierung ist daher keine innere Gesetzmäßigkeit, sondern eine Epiphänomenalität der Interaktion: ein Nebenprodukt der kulturellen, technischen und ökonomischen Bedingungen, die ihre Verwendung strukturieren. Die eigentliche Ursache liegt nicht im Modell, sondern in der Kommunikationskultur, die sich seiner bedient.

5 | Eine notwendige Korrektur: der linguistische Osmose-Effekt

Der tiefgreifendste sprachliche Einfluss großformatiger Modelle entsteht nicht in der Produktion, sondern in der Rezeption. Im Folgenden wird dieser rezeptive Mechanismus als „linguistischer Osmose-Effekt“ bezeichnet: eine stille, kapillare Durchdringung individueller Sprachwahrnehmung durch wiederkehrende algorithmische Ausdrucksmuster. Während die intentional gesteuerte Promptgestaltung nur eine partikulare Ebene des Sprachwandels erklärt, entfaltet sich der eigentliche kulturelle Effekt im unbewussten Konsum maschinell geglätteter Texte.

Studierende, journalistische Redaktionen, Unternehmen und digitale Öffentlichkeiten bewegen sich täglich in Textlandschaften, die vollständig oder teilweise durch Modelle geprägt wurden. Dadurch bildet sich eine ästhetische Normalität heraus – ein kulturelles Empfinden von „Klarheit“, „Professionalität“, „Neutralität“ –, das algorithmischer Herkunft ist, jedoch selten als solche reflektiert wird.

Dieser Prozess ist nicht metaphorisch zu verstehen, sondern lässt sich präzise soziolinguistisch verorten. Der linguistische Osmose-Effekt entspricht gut dokumentierten Mechanismen sprachlicher Transformation, wie sie historisch durch Mediensprachen bezeugt sind (siehe die ausführliche Einordnung in Abschnitt 7).

5.1 | Soziolinguistische Prozesse

Der Osmose-Effekt beschreibt somit eine diffuse, kapillare Durchlässigkeit zwischen maschinell erzeugten Sprachmustern und individuellen Schreib- und Wahrnehmungsgewohnheiten. Er operiert über etablierte soziolinguistische Mechanismen:

- Enregisterment: Sprachliche Muster werden sozial verankert, erkennbar und reproduzierbar. Die algorithmische Glätte wird zu einem identifizierbaren, wenn auch entleerten, Register.

- Indexikalität: Formen tragen soziale Bedeutungen und signalisieren Zugehörigkeiten. Die maschinelle Sprache indexiert Neutralität und Effizienz, auch dann, wenn diese Bedeutungen durch die Automatisierung abgeschwächt sind.

- Normdiffusion: Häufig rezipierte Muster werden als „standardgemäß“ internalisiert, unabhängig von ihrem Ursprung.

Man muss keinen Prompt formulieren, um stilistisch beeinflusst zu werden; es genügt, in einer Kommunikationsumwelt zu leben, die zunehmend von algorithmisch geglätteten Sprechweisen durchdrungen ist.

5.2 | Sedimentation und Normbildung

Durch die ubiquitäre Präsenz maschinell erzeugter Texte werden bestimmte ästhetische Normen stillschweigend stabilisiert:

- Kürze als Kompetenz,

- Neutralität als Professionalität,

- syntaktische Einfachheit als Verständlichkeit,

- lexikalische Glätte als Seriosität.

Diese Normen wirken nicht als bewusster Imperativ, sondern als kulturelle Selbstverständlichkeit, die über Rezeption sedimentiert wird. Sprachliche Glättung wird so nicht nur produziert, sondern internalisiert und normativ verfestigt.

5.3 | Konsequenz

Der linguistische Osmose-Effekt erweitert die Reichweite der zuvor beschriebenen Verschiebungen erheblich:

Er macht deutlich, dass die transformative Kraft nicht in der modellseitigen Produktion liegt, sondern in der kollektiven, oft unbewussten Übernahme maschinell geformter Ausdrucksmuster. Die Rekonfiguration der Sprachökologie vollzieht sich somit nicht im Schreiben allein, sondern vor allem im Lesen.

6 | Systematische Verschiebungen – eine ausführliche Analyse

Im Folgenden werden jene sprachökologischen Verschiebungen entfaltet, die sich im Gefolge großformatiger Sprachmodelle abzeichnen. Diese Veränderungen sind weder monokausal noch degenerativ; sie markieren vielmehr eine linguistische Rekonfiguration, deren Effekte auf unterschiedlichen Ebenen sichtbar werden: lexikalisch, syntaktisch, stilistisch, pragmatisch und kulturell.

6.1 | Homogenisierung lexikalischer Oberflächen

Maschinelle Sprache privilegiert jene lexikalischen Marker, die in ihrem Trainingskorpus statistisch dominant sind: grundsätzlich, allerdings, dennoch, im Wesentlichen, währenddessen. Diese Termini fungieren als Fokusmarker eines algorithmisch Normalen, eines universellen Basisformats, das kulturelle Färbungen neutralisiert.

Seltenes Vokabular, regionale Register, gruppenspezifische Lexeme oder poetische Wortfelder verlieren dabei an Sichtbarkeit – ein Prozess, der weniger als Verarmung denn als lexikalische Standardisierung zu verstehen ist, vergleichbar mit Effekten normierender Medien-, Rechts- und Verwaltungssprachen.

6.2 | Verlust individueller Schreibhandschrift

Sprachmodelle erzeugen tendenziell glatte, höflich-neutrale, konfliktvermeidende Formulierungen.

Dadurch werden die prosodischen Mikrostrukturen persönlicher Sprache – Atemrhythmen, Unregelmäßigkeiten, syntaktische Mutproben, idiosynkratische Textur – überschrieben.

Es entsteht eine De-Idiosynkrasierung, eine stilistische Entpersonalisierung, die den individuellen Stilhabitus zugunsten eines generischen Diskurskörpers zurückdrängt. Dieser Verlust ist nicht primär semantisch, sondern ästhetisch: Die Sprache verliert Stimme.

6.3 | Abschwächung syntaktischer Ambition

Sprachmodelle vermeiden syntaktische Risiken, da komplexe Satzarchitekturen im Optimierungsprozess nicht belohnt werden.

Dies führt zu einer Reduktion syntaktischer Varianz:

- Komplexe Perioden weichen modularen Satzfolgen,

- ungewohnte Verklammerungen werden geglättet,

- überraschende Verschränkungen von Nebensätzen weitgehend eliminiert.

Es entsteht eine globale syntaktische Mittelzone – ein weltkompatibles Satzformat, das kulturelle Differenzen nivelliert und funktionale Lesbarkeit priorisiert.

6.4 | Bedeutungsdrift durch technolinguistische Wiederholung

Regelmäßig reproduzierte Terme wie robust, effizient, skalierbar oder performant werden semantisch umcodiert.

Ihre ursprüngliche Polysemie verengt sich zugunsten einer technokratischen Bewertungssprache. Bedeutungen werden nicht verarmt, sondern asymmetrisch verschoben – eine Form semantischer Sedimentierung, in der funktionale statt metaphorischer oder kontextuell variabler Lesarten dominant werden.

6.5 | Schwund kultureller Mikronuancen

Dialekte, subkulturelle Sprachspiele, milieuspezifische Ironien und gruppenspezifische Pragmatiken erscheinen in maschinellem Text nur abgeschwächt.

Diese Phänomene tragen enorme soziolinguistische Bedeutung – sie indexieren Zugehörigkeit, codieren Machtverhältnisse und markieren Identität.

Ihr Verlust ist weniger Erosion als Deindexikalisierung:

Die Sprache löst sich von sozialer Textur und gewinnt abstrakte Allgemeinheit. Sie wird anschlussfähig, aber weniger situiert.

6.6 | Algorithmische Normbildung

Wiederkehrende Formulierungscluster – in diesem Kontext, grundsätzlich ist festzuhalten, im weiteren Sinne, unter Berücksichtigung – erzeugen schleichend normative Erwartungshorizonte:

- Was als „gut geschrieben“ gilt,

- was als „professionell“ erscheint,

- was als „angemessen“ wahrgenommen wird.

Diese Prozesse gleichen einer diskursiven Auto-Normierung, wie man sie aus journalistischen Stilbüchern kennt – nur dass sie hier algorithmisch emergieren. Es handelt sich nicht um Verarmung, sondern um Diskursnormalisierung.

6.7 | Entstehung einer translinguistischen Mittelzone

Durch die globale Verfügbarkeit maschineller Texte entsteht ein Register, das weder lokal noch kulturell verankert ist – ein sprachökologischer Raum, der sich der territorialen und sozialen Indexikalität weitgehend entzieht.

Zur terminologischen Präzisierung:

- „Translinguistische Mittelzone“ bezeichnet dieses Phänomen aus soziolinguistischer Perspektive: ein emergentes Register jenseits lokaler Varietäten und sozialer Verortungen.

- „Universales Basisregister“ beschreibt es stilistisch: neutral, anschlussfähig, funktional geglättet.

- „Nullstil“ ist die polemische Kurzformel der öffentlichen Debatte – eine zugespitzte Kritik an eben dieser funktionalen Entortung.

Alle drei Begriffe erfassen dasselbe sprachökologische Feld, jedoch aus unterschiedlichen analytischen Blickwinkeln.

Gemeint ist jeweils ein Register, das:

- anschlussfähig,

- international kompatibel,

- aber kulturell entortet.

Es trägt keine Geschichte, keine Körperlichkeit, keine sozialen Marker.

In dieser funktionalen Effizienz liegt seine Stärke – und seine Ambivalenz.

6.8 | Emergenz maschineller Stilfiguren (produktive Dimension)

Die zuvor beschriebenen Registerverschiebungen betreffen primär die Textoberflächen; daneben entsteht jedoch eine zweite, produktive Ebene: Sprachmodelle generieren Stilphänomene, die in dieser spezifischen Form erst durch maschinelle Sprachproduktion möglich werden. Die Transformation ist daher nicht nur reduktiv, sondern auch inventiv.

6.8.1 | Semantische Hyperkorrektur

Überpräzise, überlogisch verschränkte Begriffsverkettungen, die Kohärenz durch Intensivierung statt Bedeutungsökonomie erzeugen:

„Die epistemische Kohärenz dieses Arguments oszilliert entlang der Achse algorithmischer Verdichtung.“

6.8.2 | Metaphern-Kollisionen

Hybride, oft surreal anmutende Bildfelder, in denen unterschiedliche semantische Domänen inkongruent überblendet werden:

„Der algorithmische Faden durchwebt das Gewebe der Semantik und wirft einen architektonischen Schatten des Diskurses.“

6.8.3 | Algorithmische Intertextualität

Automatisch rekombinierte Muster aus wissenschaftlichen, administrativen und publizistischen Registern, die neue, maschinell generierte Hybridformen hervorbringen:

„Unter Berücksichtigung der operationalisierten Erkenntniskorridore lässt sich im weiteren Sinne von einer stabilisierten Evidenzarchitektur sprechen.“

6.8.4 | Abstrakte Höflichkeit

Syntaktisch makellose, semantisch glatte Empathieformeln, die Emotionalität simulieren, jedoch entkernt bleiben:

„Ich begleite Sie sehr gerne durch Ihren Prozess der Klärung.“

6.8.5 | Automatisierte Übergangsrhetorik

Routinehafte Bindeglieder wie „in diesem Kontext“, „unter Berücksichtigung“, „im weiteren Sinne“, die Kohärenz performieren, ohne sie dialogisch zu erarbeiten.

7 | Historische Vergleichsperspektive: Sprachökologien im Wandel

Sprachliche Ökologien waren nie statisch. Sie standen stets in einem Wechselverhältnis zu technischen Medien, ökonomischen Strukturen und kulturellen Institutionen. Wer großformatige Sprachmodelle heute als singuläre Bedrohung begreift, unterschätzt, wie oft Sprache bereits tiefgreifenden medialen Transformationen ausgesetzt war.

7.1 | Buchdruck: Standardisierung und Nationalliteraturen

Mit der Erfindung des Buchdrucks verschob sich das Gefüge der Schriftkultur radikal.

- Orthografie und Lexik wurden zunehmend vereinheitlicht,

- regionale Schreibtraditionen traten hinter standardisierten Normen zurück,

- „Nationalliteraturen“ entstanden auf der Basis einer technisch ermöglichten Verbreitung und Wiederholung bestimmter Schreibweisen.

Was aus heutiger Perspektive als kultureller Gewinn erscheint – Lesbarkeit, Standardisierung, Kanonbildung –, wurde zeitgenössisch durchaus als Verlust an regionaler Eigenart und oraler Tradition empfunden. Schon hier zeigt sich: Homogenisierung und Pluralisierung treten historisch oft gemeinsam auf.

7.2 | Massenmedien: Vorformatierung der Alltagssprache

Mit Radio und Fernsehen traten neue Instanzen sprachlicher Normierung auf.

- Ausgesprochene Sprache wurde zu einem öffentlichen Modell,

- bestimmte Aussprachevarianten (oft: „Hochsprache“) erhielten Prestige,

- syntaktische Muster journalistischer und moderierender Rede prägten sich tief in den Alltagsgebrauch ein.

Die Massenmedien produzieren bis heute eine vorgeformte Alltagssprache, in der Spontanität und normierter Ausdruck unauflöslich verschränkt sind. Auch hier gilt: Die Klage über „Sprachverfall“ begleitete den Prozess von Beginn an.

7.3 | Digitale Kommunikation: Fragmentierung und neue Textualitäten

Mit der Digitalisierung und der Verbreitung internetbasierter Kommunikation wandelten sich Textsorten, Rhythmen und Längen:

- E-Mail, Chat, soziale Medien und Messenger erzeugen neue Mischformen zwischen mündlich und schriftlich,

- Satzbau verkürzt sich, Ellipsen, Abkürzungen und Emojis übernehmen Teilfunktionen der Syntax,

- Hypertext, Threads und Memes verändern die Kohärenzformen von Text.

Was konservative Sprachkritik als Zerfall interpretiert, kann ebenso als Explosion neuer Textualitäten gelesen werden: Mikroformen, situative Codes, hybride multimodale Kommunikation.

7.4 | KI als nächste Phase der medialen Serie

Vor diesem Hintergrund erscheint KI nicht als historischer Ausnahmezustand, sondern als nächste Phase einer langen Reihe medial vermittelter Sprachtransformationen.

Wie Buchdruck, Massenmedien und digitale Kommunikation zuvor:

- reorganisiert KI die Bedingungen der Produktion und Rezeption von Sprache,

- erzeugt neue Normen und hebt alte auf,

- führt zugleich zur Nivellierung bestimmter Differenzen und zur Emergenz neuer Ausdrucksformen.

KI ist also keine Anomalie, sondern ein weiterer Schritt in einer Serie von Rekonfigurationen, in denen Sprache regelmäßig neu verteilt, neu hierarchisiert und neu funktionalisiert wird. Die eigentliche Frage ist daher nicht, ob KI Sprache verändert, sondern wie diese Veränderung in die bereits bestehende Geschichte medialer Sprachverschiebungen einzuordnen ist.

8 | Normative Dimension: Wer trägt Verantwortung?

Wenn Sprachmodelle als Resonanzräume und Verstärker bestehender Diskurse verstanden werden, verschiebt sich die Frage der Verantwortung konsequent weg von der Technik hin zu den kulturellen Institutionen, die Sprache lehren, regulieren, verbreiten und gestalten.

Die zentrale normative Einsicht lautet:

Die Zukunft der Sprache ist nicht im Algorithmus verankert, sondern in den sozialen Strukturen, die seine Verwendung rahmen.

8.1 | Bildung als Immunisierungsraum: Pflege stilistischer Vielfalt und kritischer Reflexion

Bildungseinrichtungen – Schulen, Hochschulen, Erwachsenenbildung – tragen eine doppelte Verantwortung: Sie müssen nicht nur Konsum, sondern kompetente Interaktion mit maschineller Sprache ermöglichen.

- Vielfalt kultivieren: Sie müssen stilistische Vielfalt (Dialekte, Soziolekte, fachsprachliche Register, literarische Formen) nicht nur zulassen, sondern aktiv kultivieren.

- Kritische Reflexion vermitteln: Sie müssen kritische Sprachreflexion vermitteln: Wie funktionieren KI-Texte? Welche Muster prägen sie? Wie erkennt man algorithmische Glättung und wie überschreitet man sie bewusst?

Bildung kann so zu einem Raum werden, in dem Lernende maschinelle Sprache transformieren und überschreiten.

8.2 | Medien als Kuratoren: Aktive Wahrung der Registerpluralität

Medieninstitutionen – Presse, Rundfunk, Online-Plattformen – sind entscheidende Akteure in der Verteilung sprachlicher Normen und müssen ihre Rolle aktiv gestalten. Wenn Redaktionen KI zur Texterstellung oder -bearbeitung nutzen, entscheidet die redaktionelle Praxis mit darüber, ob nur noch ein einziges, glattes Standardregister dominiert (Agent der Nivellierung), oder ob unterschiedliche Stimmen, Tonlagen, Stile bewusst nebeneinander bestehen dürfen (Kurator der Pluralität).

Da Medien den größten Teil alltäglicher Rezeption strukturieren, entscheiden sie unmittelbar mit darüber, welche sprachlichen Muster überhaupt in den Osmose-Effekt eingespeist werden.

Medien können sich daher aktiv gegen die osmotische HoDa Medien den größten Teil alltäglicher Rezeption strukturieren,mogenisierung stellen, indem sie Vielfalt anzeigen, markieren und wertschätzen.

8.3 | Politik als Schutzrahmen: Schutz sprachlicher Minderheiten und kultureller Eigenarten

Politik und Gesetzgebung tragen Verantwortung für den Schutz sprachlicher Minderheiten und kultureller Ausdrucksformen, die im maschinellen Mainstream schnell marginalisiert werden können. Regulatorische Maßnahmen (Förderprogramme, Sprachrechte, mediale Sichtbarkeit) können helfen, dass Sprachen und Varietäten nicht im Rauschen der globalen Basisregister verschwinden. KI kann hier sowohl Gefahr (Nivellierung) als auch Chance (digitale Sichtbarmachung) sein.

Weil politische Rahmensetzungen den medialen und institutionellen Raum strukturieren, definieren sie mit, welche Varietäten im öffentlichen Diskurs präsent genug sind, um überhaupt in den Osmose-Kreislauf einzutreten.

8.4 | Kunst und Literatur als Labor: Räume experimenteller Sprache

Kunst, Literatur, Theater, Musik und performative Praktiken sind jene Felder, in denen Sprache am freiesten experimentiert. Gerade hier kann das LLM als ästhetischer Anlass produktiviert werden:

– als Material, das verfremdet, dekonstruiert und ironisiert wird,

– als Spiegel, an dem sich das Eigene (die menschliche Idiosynkrasie) schärfer konturiert,

– als Werkzeug, um neue hybride Formen zwischen menschlichem und maschinellem Ausdruck zu erzeugen.

Kunst ist nicht dazu da, die Norm zu stabilisieren, sondern ihre Grenzen sichtbar zu machen.

Weil Kunst neue Formen der Wahrnehmung und Sensibilität erzeugt, kann sie sprachliche Muster produzieren, die selbst wieder osmosefähig werden und alternative Register in den gesellschaftlichen Umlauf einspeisen.

8.5 | Die Transformation als Gestaltungsimperativ

Aus normativer Sicht ist entscheidend: Die Transformation ist nicht bloß etwas, das „mit uns geschieht“. Sie ist gestaltbar – durch Bildung, Medienpraxis, politische Rahmung und künstlerische Produktion.

Die Verantwortung liegt damit nicht bei der „Technik an sich“, sondern bei einer Kultur, die entscheidet:

- ob sie sich in algorithmische Glättung fügt,

- oder ob sie sich ihrer Werkzeuge bewusst bedient, um sprachliche Vielfalt zu bewahren und neue Ausdrucksräume zu eröffnen.

9 | Schluss: Verdichtung der Kernthese

9.1 | Keine Erosion, sondern Transformation

Die Rede von der linguistischen Erosion projiziert reale Verlusterfahrungen auf ein technisches System, das weder Intentionalität noch normative Zielsetzung besitzt.

Die eigentlichen Verschiebungen entstehen:

- aus menschlicher Nutzung,

- aus massenmedialer Rezeption,

- aus kultureller Osmose,

- aus unbewusster Norminternalisierung.

Sprachmodelle vereinfachen nicht autonom;

sie materialisieren jene Formen, die in ihrem kommunikativen Ökosystem bereits hegemonial sind.

Die treffendere Diagnose lautet daher nicht: „Die Sprache erodiert“, sondern:

Die Sprache wird transformiert – und zwar durch uns.

9.2 | Modelle als Resonanzkörper, nicht als Motor des Niedergangs

Großformatige Sprachmodelle sind kein Motor des kulturellen Verfalls.

Sie sind Resonanzkörper, in denen kulturelle Formen neue Gestalt annehmen.

Die hier beschriebene Transformation ist weder von Natur aus gut noch schlecht – sie ist zunächst einmal machtvoll. Ob wir in ihr eine Entfremdung von Sprache oder eine Erweiterung kommunikativer Möglichkeiten erkennen, ist keine technische, sondern eine kulturelle und ethische Bewertungsaufgabe, die erst beginnt.

9.3 | Die eigentliche Frage

Die entscheidende Frage lautet daher nicht:

„Was macht die Maschine mit unserer Sprache?“

sondern:

„Welche Formen von Sprache wird eine Kultur hervorbringen,

die sich zunehmend in Resonanz mit maschinellen Sprechweisen bewegt?“

Diese Perspektive verschiebt den Fokus:

weg von einer technikzentrierten Alarmrhetorik,

hin zu einer kulturzentrierten Verantwortungsrhetorik.

9.4 | Bewahren, immunisieren, kultivieren

Vor diesem Hintergrund stellen sich drei handlungsleitende Fragen:

- Welche sprachlichen Eigenarten – Dialekte, Stilprägungen, Textsorten – wollen wir bewusst bewahren?

- Welche Ausdrucksformen wollen wir gezielt gegen osmotische Glättung immunisieren, etwa durch Bildung, Medienpolitik oder künstlerische Praxis?

- Welche maschinell co-evolvierenden Ästhetiken wollen wir als Bereicherung begreifen und kultivieren, anstatt sie pauschal als „künstlich“ zu diskreditieren?

Diese Fragen markieren kein Ende der Debatte, sondern ihren produktiven Anfang.

9.5 | Der letzte Satz

In zugespitzter Form lässt sich die Kernthese so verdichten:

Die Zukunft der Sprache liegt nicht im Algorithmus,

sondern in der kulturellen Praxis, die ihn rahmt.

Nicht Erosion, sondern Transformation –

und wir sind es, die ihre Richtung bestimmen.